¿Puede realmente el universo ser tan extraño como la teoría cuántica sugiere? ingeniosos experimentos se están acercando a la solución de esta pregunta.

Cuando Rupert Ursin estaba de pie en la oscuridad en el punto más alto de La Palma en las Islas Canarias le resultaba aterrador."Realmente da miedo", dice. La oscuridad extendiéndose hacia el océano Atlántico a unos 15 kilómetros de distancia era menos importante que el enorme desafío técnico por delante -y tal vez un poco a causa de los fantasmas que él estaba tratando de poner a descansar en paz.

Ursin y sus colegas del Instituto de Óptica Cuántica e Información Cuántica en Viena, Austria, estaban allí esa noche para ver si podían emitir un haz de fotones de luz a la apertura de 1 metro de un telescopio en la isla de Tenerife, a 144 kilómetros de distancia .Incluso en un buen día, cuando Teide, un pico volcánico de Tenerife, es claramente visible desde La Palma, eso sería una hazaña de precisión alucinante. Intentarlo en la oscuridad parecía absurdo."Por la noche no sé sabe dónde la otra isla está", dice Ursin. "Usted se pierde; no tienes idea de lo qué haces"

Durante el día, sin embargo, millones y millones de fotones zumbando alrededor habrían hecho el experimento imposible. Y así, en las noches sin luna, los investigadores apagarían las luces en su laboratorio y se deslizarían afuera a un cielo nocturno iluminado sólo por la Vía Láctea.

¿Para qué? Para tratar de resolver uno de los debates de más larga duración en la física moderna. Para disponer de otra ambigüedad en nuestra comprensión básica de como la naturaleza funciona. Para responder a una de las preguntas más fundamentales de todas: es la realidad cuántica real? .

fig nº 1, seguimiento del láser en el observatorio de Tenerife.Crédito.(Imágen: Rupert Ursin)

fig nº 2 ,el experimento de las islas Canarias ayuda a cerrar posibles brechas en experimentos diseñados para mostrar (si la propiedad de entrelazamiento de la mecánica cuántica o si una acción fantasmal a distancia) realmente existen en la naturaleza.Crédito.: Rupert Ursin.

Fué a mediados de 1920 que dos grandes bestias de la física moderna, Niels Bohr y Albert Einstein (ver "duelistas cuánticos" al final del artículo), fueron los primeros en abordar esta cuestión . Para entonces ya había quedado claro que la física clásica no podía explicar una letanía de los fenómenos de pequeña escala, por ejemplo, cómo la luz interactúa con la materia, o por qué los electrones orbitán y no se mueven en espiral hacia el interior estrellándose en el núcleo atómico.

La nueva teoría de la mecánica cuántica, era una píldora amarga de tragar. Atrás quedaban las viejas certezas y hacia abajo las relaciones directas entre la causa y el efecto del mecanismo de relojería, del universo newtoniano. En su lugar estaba un mundo poblado por partículas difusas que eran al mismo tiempo ondas , que se influenciaban entre sí, sin aparentemente razón, y que al parecer podrían existir en muchos estados a la vez hasta que la atenta mirada de un observador las perturbara a ellas.

Para Bohr, si no hemos podido conseguir utilizar nuestras cabezas alrededor de eso entonces, el problema reside en nuestras cabezas, no con la mecánica cuántica. Desagradable, como ella podría ser a nuestro cerebro en sintonía con lo clásico, la teoría era una descripción completa y fundamental de cómo funcionaba el mundo.

Einstein no estaba de acuerdo. Pensó que la rareza de la mecánica cuántica implicaba que a la teoría le faltaba algo. Se convenció de que una capa más profunda de la realidad se escondía debajo de su superficie, la cual se regía por unas aún sin descubrir "variables ocultas" que funcionaban de acuerdo a las reglas conocidas de la física clásica (véase el "mundo oculto de Einstein" al final del artículo) . EL debate entre Bohr y Einstein continuó-con firmeza, decoro y sin respuesta definitiva durante décadas. No fue sino hasta 1964, después de que ambos hombres habían muerto, que el primer indicio de una resolución apareció. Llegó por cortesía de John Bell, un investigador de 36 años de edad, en el laboratorio europeo de física de partículas del CERN, cerca de Ginebra, Suiza. Su idea era que los casi argumentos filosóficos de Bohr y Einstein podían ser reformulados matemáticamente.

Bell comenzó por considerar que las partículas están correlacionadas, en el sentido de que la medición de las propiedades de una le dice a usted las propiedades de las demás. La existencia de tales correlaciones no es en sí sorprendente: si las leyes tales como la conservación de la energía o momento se cumplen, esperaríamos que las propiedades tales como la velocidad o la posición de las partículas emitidas por la misma fuente, al mismo tiempo estarían relacionadas. Sin embargo, Bell obtuvo una expresión matemática, llamada la desigualdad, para describir la cantidad máxima de correlación posible si dos condiciones estimadas a nuestras intuición clásica, pero al parecer violadas por la mecánica cuántica,mantienen: el realismo y el localismo. Realismo encarna la idea de que cualquier propiedad medible de un objeto existe en todo momento, y su valor no depende de alguien observándolo. El localismo supone que estas propiedades sólo se ven afectadas por las cosas cercanas, y no pueden ser influenciadas por nada remoto.

Aquí, entonces, estaba una prueba para que los físicos metieran sus dientes adentro. Todo lo que se necesitaba era un experimento para medir qué tan entrelazadas dos partículas de la misma fuente estaban. Si sus correlaciones violaban la desigualdad de Bell por una cantidad significativa, entonces, el realismo, el localismo o ambos habían fallado, y la rareza de la mecánica cuántica realmente existe: las partículas estaban de alguna manera misteriosamente "enredadas". Sin embargo si la desigualdad de Bell era satisfecha,entonces , alguna cosa real, local y clásica estaba tirando de las cuerdas: las variables ocultas de Einstein, por ejemplo.

Oportunamente, la realidad era algo más compleja. Resultó difícil poner en práctica las condiciones ideales necesarias para probar la desigualdad de Bell, y todos los experimentos se mostraron no concluyentes.

Entonces, a principios de 1970, un joven estudiante francés llamado Alain Aspect entró en escena. Él acababa de terminar su servicio militar obligatorio como profesor en Camerún y estaba ideando un tema de doctorado. Casualmente el papel de Bell y la historia del debate entre Bohr y Einstein, lo tenían entusiasmado. "Fue la cosa más emocionante para un experimentalista el de probar quién tenía la razón", dice Aspect , ahora en el Instituto de Óptica en Palaiseau, Francia.

Así Aspect visitó a Bell en busca de su bendición. Bell advirtió a Aspect que muchos consideran la investigación de las raíces de la realidad cuántica "chifladuras de la física ", y le preguntó si él había asegurado un trabajo. "Yo lo hice. era pequeño, pero era permanente", dice Aspect . "No podían despedirme." Esa seguridad permitió a Aspect embarcarse en una búsqueda de siete años para averiguar quién estaba en lo cierto: Bohr o Einstein.

Los experimentos de Aspect ampliamente siguieron un patrón establecido en las pruebas anteriores de la desigualdad de Bell.Los átomos fueron estimulados en primer lugar para emitir pares de fotones que estuvieran correlacionados en sus estados de polarización.Estas polarizaciones se midieron en dos detectores separados, los cuales son, por convención, mantenidos por dos personajes ficticios llamados Alice y Bob (ver fig nº 3).

fig nº 3 si la teoría cuántica es correcta dos fotones emitidos desde una misma fuente al mismo tiempo estarán en dos estados de polarización a la vez permitiéndo la medición de uno para influenciar la medición del otro.Crédito.Rupert Ursin.

Eso depende de la medición de un gran número de pares de fotones para obtener resultados estadísticamente significativos.Por aquel tiempo Aspect junto con sus estudiantes Philippe Grangier y Jean Dalibard, estaban listos para llevar a cabo sus pruebas definitivas, los avances en la tecnología láser estaban haciendo esto una tarea más fácil. "En 1980, tenía, por mucho, la mejor fuente de fotones entrelazados en el mundo", dice Aspect . Considerando que previamente se habían tomado horas o incluso días para obtener el número de fotones necesarios, que ahora podrían obtener en sólo 1 minuto.

Todavía era un trabajo concienzudo. Pero en 1982 los investigadores tuvieron la réplica más convincente en el debate de la realidad cuántica. No había duda de los resultados. Bohr tenía la razón: la desigualdad de Bell fue violada (ver aquí). El mundo es tan raro como la teoría cuántica dice que es. "Fue emocionante", dice Aspect .

Pero quedaron dudas molestas fué este el fin de la historia? No, es un poco de ella. Los experimentos son rara vez totalmente concluyente, y sin duda influenciados por las dudas de Einstein dada su reputación pequeñas dudas permanecieron siendo que tal vez la naturaleza había engañado a los experimentadores en el pensamiento de que la teoría cuántica es la respuesta verdadera.Incluso si las correlaciones medidas superaban el máximo de Bell, habían suficiente lagunas en los experimentos para dejar un margen de maniobra para que algo adicional a la mecánica cuántica pudiera ser la causa.

"La cuestión de si la naturaleza es local, realista o mecánico cuántica-es tan profunda y tan importante que debemos tratar de hacer estos experimentos tan limpiamente y libres de brechas o lagunas como sea posible", dijo Johannes Kofler, un teórico con el equipo de Viena."Es realmente todo acerca de descartar teorías de la conspiración de la naturaleza en contra de nosotros."

Los experimentos de Aspect ya habían hecho un excelente trabajo para tratar de cerrar una brecha que Bell había señalado - la brecha de la localidad. A menos que los detectores utilizados por Alice y Bob estén lo suficientemente separados para impedir la comunicación entre ellos a la velocidad de la luz o por debajo, alguna influencia podría propagarse a través de una capa oculta de la realidad, diciendo al detector de Alice el resultado de la medición de Bob antes de que ella ejecute su propia medición, digamos, y tal vez incluso jugueteando con los ajustes de su detector para cambiar el resultado. "Si usted permite esa comunicación, sería fácil de violar la desigualdad de Bell en el realismo local", dijo Kofler.

La fuente altamente eficiente de los fotones entrelazados y la óptica superior utilizados por Aspect han permitido a su equipo el separar a Alice y Bob en alrededor de 6 metros. Eso les dió tiempo suficiente para cambiar la configuración de los detectores después de que los fotones habían dejado la fuente, con la esperanza de obstaculizar cualquier intento de un canal de comunicación oculto para emboscar el experimento (ver aquí).

Eso fue astuto, muy astuto, pero no suficiente. El equipo tenía sólo nanosegundos para cambiar la configuración de los detectores ", lo cual no era suficiente tiempo para cambiarlos de forma aleatoria.En su lugar, tuvieron que utilizar un patrón predecible y periódico.Si algún canal oculto existía, entonces, con el tiempo los detectores utilizados por Alice y Bob podrían calcular los ajustes del otro y de nuevo dañar el experimento.

Para cortar ese tipo de cosas en el brote, en 1998 Gregor Weihs, Anton Zeilinger y sus colegas extendieron a Alice y Bob a 400 metros de distancia sobre los campos de la universidad de Innsbruck,en Austria, utilizando fibras ópticas para conectar a los detectores a una fuente de fotones colocado entre los dos. Eso les dió alrededor de 1,3 microsegundos de gracia después de que los fotones se emitieran para cambiar la configuración del detector al azar.Para cerrar la brecha de la localidad y ponerla aún más estrecha, los relojes atómicos aseguraron que las mediciones de Alice y Bob se hicieran dentro de los 5 nanosegundos de cada uno- lo suficientemente rápido como para evitar que un mensaje oculto fuera tranferido.El ensayo demostró violaciónes claras de la desigualdad de Bell (ver aquí).Por lo tanto la mecánica cuántica reinó suprema.

Y sin embargo, todavía no era una respuesta final. A medida que la brecha de la localidad fué cerrada, la atención se desvió a otras lagunas o brechas. Una de ellas fué la brecha en la imparcial toma de muestras, o la detección.Los detectores de fotones utilizados en todos los experimentos fueron ineficientes y muestreaban sólo una pequeña fracción de los fotones enviados por la fuente. ¿Qué pasa si sólo un pequeño subconjunto de los fotones eran lo suficientemente correlacionados para violar la desigualdad de Bell, y los detectores justo los muestrearon a ellos? Inverosímil, tal vez, pero no imposible.

Esta brecha se cerró por primera vez en el 2001 por un grupo liderado por David Wineland en el Instituto Nacional de Estándares y Tecnología en Boulder, Colorado. En lugar de fotones, los investigadores entrelazaron un par de iones de berilio, cada uno de los cuales podría existir en una superposición mecánico-cuántica de dos estados de energía. Dependiendo sobre cual estado se encontraba un ión, el se dispersaba en muchos o muy pocos fotones. Al sondear los iones con un láser y medir la variación en el conteo de fotones, los estados de los iones podrían ser determinados con casi el 100 por ciento de eficiencia (ver aquí).

Una vez más, las correlaciones encontradas entre los estados de los iones de berilio "eran mucho mayores de lo que podría explicarse por alguna cosa diferente que la mecánica cuántica. Pero esto también viene con una advertencia: en el punto de medición, los iones estaban a sólo 3 micras de distancia. A pesar de que la brecha de la detección fue cerrada, la brecha de la localidad permaneció abierta.

Además, había otra brecha sutil para ser considerada. Las pruebas de la desigualdad de Bell generalmente asumen que los investigadores tienen la libertad de elegir la configuración de sus detectores. Pero lo hacen? ¿Qué pasa si la fuente de las partículas tiene una manera de influir en la configuración de los detectores utilizados por Alice y Bob, de nuevo a través de alguna capa oculta de la realidad? Mediante la explotación de esta brecha de "libertad de elección" la fuente podría emitir fotones que imitaban el entrelazamiento de la mecánica cuántica.

Esto nos lleva a las Islas Canarias como se mencionó al comienzo del artículo. El objetivo de disparar fotones desde La Palma a Tenerife, un experimento que combina la experiencia de Ursin, Kofler, Zeilinger y otros-fué el de cerrar la brecha o laguna de la "libertad de elección", mientras que se mantiene la brecha de la localidad bien cerrada. Mientras un fotón entrelazado fué transmitido sobre el Atlántico a Bob en 479 microsegundos, el otro era transmitido 6 kilómetros por una fibra óptica hasta Alice, llegando a ella en 29,6 microsegundos. Generadores de números aleatorios activaron los ajustes del detector para Alice y Bob, una vez que los fotones estaban en tránsito (ver fig nº 2).

Para garantizar la libertad de elección de Alice, su generador de números aleatorios se mantuvo a 1,2 kilometros de distancia de la fuente de fotones, y la generación de números aleatorios y emisión de pares de fotones fueron cronometrados para que uno no pudiera influenciar en el otro. En Tenerife, el generador de números al azar eligió la configuración para el detector de Bob antes de la llegada de fotones de La Palma, asegurando que la fuente no podría influir en la elección de Bob-suponiendo de que no hay influencia que viaje más rápido que un fotón.

¿El resultado? Una vez más, el experimento viola espectacularmente la desigualdad de Bell (ver aquí).

Con ello, las tres brechas principales-localidad, justo muestreo y la libertad de elección-al parecer han sido cerradas. ¿El debate entre Einstein y Bohr finalmente se ha resuelto, a favor de Bohr?

Tal vez. Mientras que algunos están manteniéndo cosas interesantes por descubrir con cada vez más matizada brechas(véase "El colapso de la realidad" al final del artículo), observadores demasiado escrupulosos cuentan que todavía no se ha diseñado un experimento que cierre las tres lagunas principales de forma simultánea. Paul Kwiat y el premio Nobel Anthony Leggett, ambos de la Universidad de Illinois en Urbana-Champaign, están al frente de un equipo para intentar eso.Usando una fuente de luz potente, generadores de números aleatorios vertiginosamente rápidos y detectores de alta eficiencia, esperan crear una prueba libre de lagunas o brechas.

Leggett no espera ninguna sorpresa. "Sería realmente una clase muy rara de conspiración de la naturaleza si todo había trabajado bién cuando se cerraron dos de las tres brechas en un experimento, y luego cuando se cierren tres al mismo tiempo, las cosas vayan mal", dice.

Más provocadora es la cuestión de si en realidad estamos en libertad para cerrar la brecha de la "libre elección". ¿Qué pasa si vivimos en un mundo completamente determinista, donde incluso el resultado de un generador cuántico de números aleatorios está condenado de antemano? Eso nos convierte en meros peones en un juego mayor. "Si el universo funciona de manera determinista, no hay nada que se pueda hacer como un experimentalista," dice Kofler.

Pero para la gran mayoría de los físicos lo cual no es la principal preocupación, dice Leggett. El punto es que una teoría de variables ocultas locales-realista, como era preferida por Einstein, no es una viable descripción de la naturaleza. Mientras que la mecánica cuántica puede no ser la última palabra,pero sin duda es la mejor descripción de la realidad que tenemos ahora.

Así, Einstein estaba equivocado? Ese es el punto que falta, dice Zeilinger. "Sí, Einstein estaba equivocado acerca de la realidad", dice. " Me gustaría mucho escuchar sus comentarios sobre la situación si estuviera vivo." Pero nos obliga a examinar las bases de la mecánica cuántica muy de cerca, dice Zeilinger, las preocupaciones de Einstein nos han entregado una teoría que, sin embargo a pesar de ser extraña, es la mejor enraizada a la realidad que cualquiera que le precedió.

La motivación suficiente para las noches oscuras en la cima de La Palma, explorándo un horizonte negro en busca de un distante objetivo de fotones ,es que si los fantasmas de Bohr y Einstein hubieran estado rondando aquellas vigilias iluminadas por las estrellas, entonces ellos dos habrían tenido motivo de una calmante satisfacción: Bohr porque los investigadores han confirmado una vez más su visión del mundo;y Einstein al estar seguro de que se habían tomado todos los caminos hasta la cumbre.

El mundo oculto de Einstein.

Einstein no estaba convencido por la teoría cuántica, y en 1935 salió al aire sus inquietudes en un documento escrito con dos jóvenes físicos, Boris Podolsky y Nathan Rosen, llamado "¿Puede la descripción mecánico-cuántica de la realidad física ser considerada completa?" (ver aquí).

En ella, se formuló lo que llegó a ser conocido como la paradoja EPR. Para que una teoría sea completa, el trío argumentó, que ella debe describir cada elemento de la realidad física. Si un objeto en movimiento por ejemplo tiene una posición y momento , la teoría debe incluir elementos, o "variables", que le diga a usted sus valores.

Si bien esto funciona cuando se habla por ejemplo de coches, en el minúsculo mundo cuántico las cosas no son tan sencillas. De acuerdo con el notorio principio de incertidumbre establecido por Werner Heisenberg en 1927 sólo se puede extraer un valor exacto de la posición de una partícula cuando el momento se desconoce, y viceversa. Esto, dijo Einstein, lleva a una de dos conclusiones: o bien la posición y el momento no existen simultáneamente, o la mecánica cuántica como una descripción de la realidad es incompleta.

Una explosión que envía dos piezas de metralla disparadas en direcciones opuestas se explica fácilmente por la física clásica. Hay una conexión fácil de verificar entre los fragmentos la velocidad, la dirección y la masa, que se fijan en el momento de la explosión de acuerdo a la ley de conservación del momento.

Una situación similar en la mecánica cuántica, en cambio, es más problemática. Imaginen una partícula en reposo desintegrándose en dos partículas que se disparan en direcciones diferentes. De acuerdo con el tipo de interpretación de la física cuántica favorecida por Niels Bohr y otros pioneros de la teoría cuántica, las propiedades de partículas no están claramente definidas hasta que se midan. Sin embargo, midiéndo la posición o momento de una partícula de inmediato se fija la posición o momento de la otra en otra parte del espacio, a pesar de que era previamente indefinida. ¿Cómo este cambio en el estado puede ser comunicado de inmediato a través del espacio?

No, dijo Einstein, a través de alguna "acción fantasmal a distancia", como se deduce por la mecánica cuántica. En su lugar, cree que debe haber un elemento de una teoría subyacente-unas "variables ocultas" - que establecen los resultados de las mediciones de antemano, tanto como la conservación del momento establece los resultados de las mediciones de los fragmentos de metralla en el caso clásico. La mecánica cuántica tal como se formula debe ser una descripción incompleta de la realidad, concluyó.

duelistas cuánticos.

En su annus mirabilis de 1905, Einstein no sólo propuso su teoría de la relatividad especial y la equivalencia masa-energía con la ecuación E = mc2, sino también se convirtió en la primera persona en atribuir una realidad física a la cuántica, un concepto introducido por Max Planck cinco años antes.

Einstein describió la liberación de electrones desde la superficie de un metal iluminado el llamado efecto fotoeléctrico en términos de la acción de paquetes pequeños, discretos de energía de la luz: los fotones. Fué por esta idea que recibió el premio Nobel de Física en 1921.

En 1913, Bohr utiliza el principio de cuantificación para postular que los electrones en los átomos sólo pueden existir en estados discretos de energía , y así se explicó el espectro de la luz emitida por un átomo de hidrógeno. Este trabajo le garantizó que siguiera a Einstein con el premio Nobel de Física en 1922.

Bohr pasó a desarrollar el principio de la complementariedad, la piedra angular de la dominante “interpretación de "Copenhague" de la teoría cuántica. Esta indica que el mundo cuántico es a la vez onda y partícula , y es el acto de la medición el que hace que se muestre una cara u otra.

colapso de la realidad.

A pesar de que las brechas principales en las pruebas de la mecánica cuántica están cerradas otras se abren. Tomen la brecha del "colapso de la localidad " , una idea de Adrian Kent de la Universidad de Cambridge.

De acuerdo a muchas interpretaciones de la teoría cuántica, un par de fotones entrelazados existen en una superposición de estados cuánticos hasta el punto de la medición, momento en el que se colapsa en un estado específico. Los experimentos realizados hasta ahora han asumido que este colapso es instantáneo. Pero no lo es. En las interpretaciones que requieren que los eventos sean registrados por la conciencia humana para que los estados colapsen, se necesita tanto como 0.1 segundos.

Eso significa que un estado cuántico podría señalar su colapso a otra ubicación remota antes de que el colapso del segundo estado pudiera ser registrado. Para cerrar esta brecha, los seres humanos reales tendrían que registrar los hechos y ser espaciados más de 0,1segundos-luz en separación -alrededor de 30.000 kilómetros (ver aquí).

"Me parece exagerado", dice el Premio Nobel Anthony Leggett, de la Universidad de Illinois en Urbana-Champaign. "Pero por otro lado, si usted me hubiera dicho en 1985 que en 2010 la gente iba a estar haciendo este tipo de experimento a más de 100 kilómetros,le hubiera dicho que debe estar bromeando."

fuente de la información:

http://www.newscientist.com/article/mg20928011.100-reality-check-closing-the-quantum-loopholes.html

Una de las prioridades más altas de todo el campo de la física de partículas es la búsqueda de partículas predichas por la supersimetría,una teoría que aspira a explicar gran parte de la física que no puede entenderse dentro del modelo estándar. Ahora, después de décadas de planificación y trabajo de miles de científicos de todo el mundo, un informe que aparece en la revista Physical Review Letters de la colaboración del ATLAS [ ver aquí ] y un documento similar de la colaboración del CMS [ ver aquí] presentan los resultados de las primeras búsquedas de la supersimetría a 7-tera electrón-voltios (TeV) en el Gran Colisionador de Hadrones (LHC) del CERN. Si bien estas primeras búsquedas no descubrieron las largamente buscadas partículas, hay buenas razones para creer que la supersimetría está ahí para ser descubierta en el LHC .

El modelo estándar (SM) de la física de partículas ha sido un éxito increíble, pero pocos físicos creen que es la historia final. El modelo no explica por qué las partículas tienen masa, la presencia de materia oscura y energía oscura en el universo, o el exceso de materia sobre la antimateria. Tampoco el modelo estándar incorpora una teoría cuántica de la gravedad. Entre las muchas teorías que van más allá del modelo estándar, son pocas las que son lo suficientemente convincentes que justifiquen un conjunto amplio y sistemático de registros para verificar si se realizan en la naturaleza. La supersimetría (SUSY) es una teoría de este tipo [ ver aquí y aquí]. Esencialmente, Susy es una teoría que predice una simetría, que aún no ha sido observada entre fermiones y bosones. Por ejemplo, cada uno de los quarks y los leptones tienen una contraparte bosónica, a menudo llamadas squarks y sleptons, y estas y otras "spartículas" se pueden buscar en las colisiones de alta energía en el LHC.

A costa de la predicción de un conjunto de nuevas partículas, SUSY proporciona una solución para una serie de problemas del modelo estándar. Por ejemplo, el modelo estándar predice un valor divergente para la corrección de la masa del bosón de Higgs, pero SUSY ofrece una manera de evitar este problema, siempre y cuando las spartículas no sean demasiado pesadas [ ver aquí, aquí y aquí ]. Otra posibilidad emocionante es que SUSY proporciona una manera de unificar las constantes de acoplamiento de las diferentes fuerzas, a muy alta energía. No hay un requisito apriori de que esto deba ocurrir, pero la unificación potencial de las fuerzas electrodébil y fuerte tiene una elegancia que es tentadora [ ver aquí]. Muchas versiones de SUSY tienen una ley de conservación extra que prohibiría el decaimiento de la partícula más ligera SUSY (neutralino). No sólo esta partícula se convertiría en un candidato a materia oscura, sino en este contexto SUSY se puede utilizar para proporcionar un cálculo completo tanto de la física del universo temprano así como de la densidad de la materia oscura reliquia, un problema central en la cosmología moderna [ ver aquí y aquí]. Por último, SUSY permite una conexión posible a la gravedad cuántica a través de la Teoría de Supercuerdas.

clasificación de las partículas supersimétricas como las predice SUSY la supersimetría dobla el número de partículas asignándole a cada fermión un bosón masivo como supercompañero y viceversa, el LHC del CERN tendrá a su cargo el recoger la antorcha que dejará el Tevatrón cuando salga de funcionamiento y deberá proseguir en la búsqueda para validar o no a la supersimetría como una realidad de la naturaleza.

Aunque una búsqueda para todas las versiones posibles de SUSY probablemente no sea posible, el LHC y sus detectores gigantes fueron diseñados para ser muy sensible a los modelos más convincentes.Las restricciones experimentales y sugerencias de la teoría ayudan a reducir el espacio de parámetros para la caza de las nuevas partículas. Los modelos de materia oscura de la cosmología favorecen una interacción débil de las partículas neutras en un rango de masas de 100 GeV/c2 . La no observación de spartículas por parte de los aceleradores del Fermilab y el LEP operando en la anterior frontera de alta energía sugiere que las masas de la mayoría de las más pesadas partículas supercompañeras tendrían que superar los cientos de GeV [ ver aquí ]. Por otra parte, las spartículas no es probable que sean mucho más altas que unos pocos TeV , si SUSY ofrece un medio para corregir la masa del bosón de Higgs. En su conjunto, no es descabellado pensar que podemos haber entrado en una ventana de oro de oportunidades ya que las masas de las spartículas bien pueden estar al alcance del LHC.

En el 2010, el LHC comenzó a producir colisiones protón-protón de alta energía y los detectores CMS y ATLAS comenzarón a recoger datos. No fue una inundación de datos para estar seguro (los experimentos del Fermilab por ejemplo han estudiado más de 250 veces más colisiones), pero la mayor energía de colisión en el LHC (más de 3. 5 veces más alta) debería de hacer mucho más fácil la producción de las spartículas deseadas. Una nueva era largamente esperada en la física de partículas ha comenzado oficialmente.

Los desafíos experimentales para poner a prueba incluso una versión sencilla de SUSY son enormes, y la literatura está repleta de opciones razonables. Dado un número semi-infinito de posibles estados finales para el estudio y los recursos limitados (y un tiempo crítico en la carrera para obtener resultados), los experimentadores han optado por empezar por centrarse en una de las más directa versiones bien estudiadas de SUSY que cumpla todos los criterios anteriores. Esta versión, que es el modelo mínimo de SUSY que también incluye el gran potencial de la unificación con la gravedad, se conoce como supergravedad mínima o mSUGRA por sus siglas [ ver aquí ,aquí,aquí y aquí]. Desde el punto de vista puramente práctico, tiene la gran ventaja de estar bien descrita por sólo unos pocos parámetros.

Si mSUGRA se realiza en la naturaleza, y las masas son lo suficientemente bajas, la enorme energía del LHC debería ser capaz de producir versiones supersimétricas de los quarks y gluones (conocido como squarks y gluinos) en grandes cantidades. Estas spartículas deberían entonces decaer rápidamente, y en función de cómo lo hacen, sus productos de desintegración pueden ser identificados por los detectores. Por ejemplo, los quarks y gluones (los cuales producen chorros de hadrones, simplemente conocidos como chorros) se pueden identificar, y lo mismo es cierto para los bosones vectoriales tales como Ws y Z, que se desintegran en los leptones conocidos (electrones, muones,o taus), o quarks (más chorros). Además de estas partículas conocidas, cada spartículas eventualmente decaería en la más ligera de las partículas supersimétricas la cual por una ley de conservación, será estable y, si es la materia oscura,será neutral y débilmente interactuánte. Por lo tanto, debería salir del detector sin interactuar con cualquier cosa. Esta firma de pistola humeante se conoce como energía "desaparecida o faltante". Dado que hay muchas formas en que las partículas SUSY pueden decaer, hay muchas combinaciones de estados finales para las partículas producidas; las colaboraciones buscan todas estas combinaciones. Por ejemplo, el CMS informó en su búsqueda de eventos con energía faltante y con una gran cantidad de chorros [ ver aquí ], mientras que el Atlas informó en su búsqueda de un leptón, energía faltante, y grán número de chorros[ ver aquí ]. Hay un montón de otros modos "dorados" de búsqueda, incluyendo múltiples leptones, chorros, y energía faltante, y los resultados de todos ellos se encuentran en camino.

Por desgracia, los datos hasta ahora son compatibles con un mundo descrito por el modelo estándar solamente. Si bien es siempre más excitante hacer un descubrimiento, un explorador debe informar sobre la sensibilidad de su búsqueda con el fin de hacer su expedición más útil a su comunidad. Como es típico en la búsqueda de SUSY, ambas colaboraciones(CMS y Atlas) colocan el 95% de nivel de confianza a los límites como una forma de transmitir la sensibilidad de su búsqueda. A modo de comparación, los más sensibles límites del Tevatron del Fermilab, en modelos comparables, pero en un solo punto en el espacio de parámetros se obtuvieron a energías de colisión de sólo alrededor de 2 TeV , pero con 100 veces más datos y excluyeron los squarks con una masa inferior a 400 GeV/c2 [ ver aquí ]. En otras palabras, aunque no se puede decir con seguridad que un squarks o gluino no existe con una masa de 400 GeV, lo que podemos decir es que si existieron dentro de ese modelo, entonces, en el 95% de los experimentos ellos debieron haber sido observados . Dado que no estaban, fueron excluidos de este nivel. En el resultado del ATLAS, los squarks fueron excluidos hasta 700 GeV/c2 en ciertos modelos [ veraquí ].El CMS reportó una sensibilidad comparable en similares, pero no idénticos modelos [ ver aquí ].

Para este tipo de búsqueda de SUSY, la antorcha ha sido completamente pasada desde Fermilab para el LHC. Si bien no hay garantía de que SUSY será descubierta en el LHC, la mayoría de los físicos piensan que la mayor parte del espacio de energía favorecido está dentro de su alcance final. Con muchos resultados del 2010 en secreto, más los datos que vienen este año al doble de la energía de colisión y tal vez 1000 veces más en un futuro no muy lejano, no es descabellado pensar que el LHC permitirá a los equipos experimentales que trabajan allí ,descubrir a SUSY si tiene una masa de 2 TeV/c2 (o menos) o sino decir "Tal vez no es correcta." la historia nos enseña que los grandes descubrimientos vienen de grandes herramientas nuevas, esperemos que la historia esté de nuestro lado de una manera u otra.

fuente de la información:

http://physics.aps.org/articles/v4/27

Una teoría radicalmente nueva en donde los planetas nacen dentro de un masivo velo de gas puede ayudar a explicar cómo recién descubiertos planetas extrasolares desarrollan su impresionante diversidad de tamaños y ubicaciones.

En la teoría, los planetas nacen en secreto, ocultos en los centros de gigantes nubes de gas lejos de sus estrellas progenitoras. La gravedad de la estrella a continuación hace tambalear a la nube planetaria, quitando una parte o todo el gas para revelar el planeta en su interior.

Dependiendo de la cantidad de gas que se extrae en el proceso, el planeta dado a conocer se asemeja a un gigante gaseoso como Júpiter, un núcleo sólido con una capa de gas como Neptuno o un cuerpo sólido como la Tierra. Sergei Nayakshin de la Universidad de Leicester en Inglaterra, describe el proceso en una próxima emisión de Monthly Notices of the Royal Astronomical Society , así como en varios artículos publicados en línea en arXiv.org.

Este principio podría explicar la abundancia de pequeños a medianos planetas extrasolares- - muchos de ellos del tamaño del planeta Neptuno - recientemente descubiertos por la sonda Kepler de la NASA que orbitan a una distancia muy cerca (de tostado) de sus estrellas ( más información aquí ). Los modelos estándar de formación de planetas se enfrentan a retos sin precedentes debido a que no pueden explicar fácilmente los diferentes tipos de planetas extrasolares descritos a partir de 1995, señala Aaron Boley teórico de la Universidad de Florida en Gainesville. "Al final del día, tenemos que explicar esta diversidad de sistemas planetarios", dice.

en una nueva teoría los planetas se desarrollan creciéndo dentro de trozos de gas gigantes que se forman en una variedad de localizaciones dentro del disco de gas y polvo alrededor de una jóven estrella .Cuándo el cuerpo migra hacia adentro la gravedad de la estrella lo despoja de parte o de todo su gas exponiéndo al planeta maduro.Credit: Seung-Hoon Cha, Nayakshin.

La teoría de Nayakshin, junto con una similar hecha por Boley y sus colaboradores, toman prestadas ideas de otros dos modelos tradicionales. En un escenario conocido como acreción del núcleo, trozos de partículas sólidas se unen en el disco de gas y polvo que rodea a una estrella joven y forman un núcleo sólido que se asemeja a Mercurio o la Tierra.El núcleo puede entonces atrapar suficiente gas para formar un Júpiter. En el otro modelo, conocido como inestabilidad gravitatoria, el gas dentro del disco de formación planetaria repentinamente se fragmenta para formar una burbuja gigante, formando un Júpiter de un solo golpe.

Por el contrario, Nayakshin comienza con la burbuja gigante de gas generada por la inestabilidad gravitacional. Entonces, él sugiere,que el polvo se deposita en el corazón de la burbuja, y en última instancia, formándo un cuerpo sólido que atrapa algo de gas de su alrededor, como en el modelo de acreción del núcleo. La dotación gaseosa alrededor del núcleo es inicialmente suave y esponjosa y se quita fácilmente. A medida que el cuerpo migra hacia el interior de su estrella y alcanza una distancia similar a la que separa a Marte desde el Sol, parte del gas puede ser arrancado por las fuerzas de marea gravitatoria de la estrella. Eliminando las capas externas de gas produciéndo planetas rocosos similares a los del sistema solar interior.

En otros casos, cuando la migración es más lenta, la dotación de gas esponjoso tiene tiempo suficiente para contraerse y ser más denso, resistiéndose al despojo por parte de la estrella. En ese caso, sólo si la burbuja se mueve muy cerca de la estrella, aproximadamente a la mitad de la separación media de Mercurio del sol, pueden las fuerzas de marea de la estrella despojar parte o la totalidad de la envoltura de gas denso. Este planeta reducido se encuentra a una distancia de "tostado" de su estrella, y podría ser una versión caliente de Júpiter, Neptuno o la Tierra, como recientemente observaron Kepler y otros telescopios en busca de planetas extrasolares.

Kepler ha demostrado que los exoplanetas del tamaño de Neptuno son muy comunes en las distancias más cercanas de sus estrellas progenitoras de lo que la Tierra está(e incluso a la mitad de la distancia Tierra-Sol), en lugar de limitarse a las partes frías exteriores de un sistema planetario como se pensaba anteriormente, dice Boley. "Determinar si la reducción de marea puede explicar una fracción considerable del tamaño de estos planetas ... es una dirección que vale la pena explorar", dice.

Jack Lissauer del Centro de Investigación Ames de la NASA en Mountain View, California, sin embargo, dice que él considera "la hipótesis como muy débil" y "la idea de formar núcleos planetarios de esta manera está lejos de ser demostrada." Además, dice, la teoría tendría problemas para explicar algunos tipos de planetas extrasolares que se han observado, tales como aquellos rico en gas con un núcleo rocoso relativamente pequeño que orbitan cerca de su estrella madre.

Alan Boss, quien desarrolló el modelo de la inestabilidad gravitacional y trabaja en la Institución Carnegie para la Ciencia en Washington, DC, tiene una opinión más. "Yo estoy a favor de tener miles de flores retoñando en el mundo de las teorías de la formación de exoplanetas – ya que en este momento es difícil elegir a los ganadores y perdedores eventuales".

la simulación muestra el nacimiento de una super Tierra, al principio los trozos de gas en amarillo se desarrollan a diferentes distancias de la estrella progenitora.Cuando los trozos se mueven hacia adentro el polvo se concentra en sus núcleos y forma objetos sólidos.Cuando los trozos son atraidos hacia la estrella progenitora,la envoltura gaseosa es despojada y un planeta sólido es revelado.

leer el estudio AQUÍ

fuente de la información:

http://www.sciencenews.org/view/generic/id/71776/title/Planets_take_shape_in_embryonic_gas_clouds

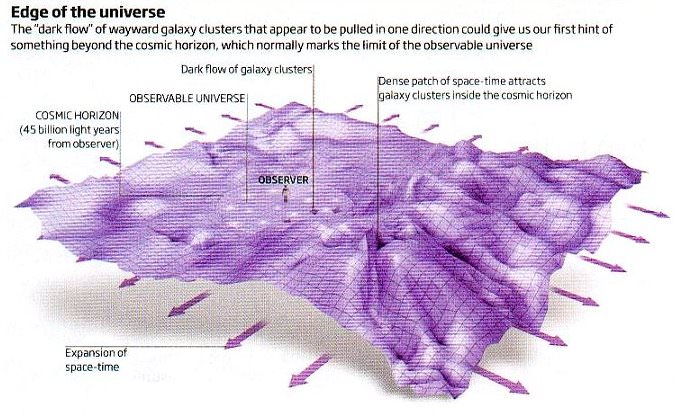

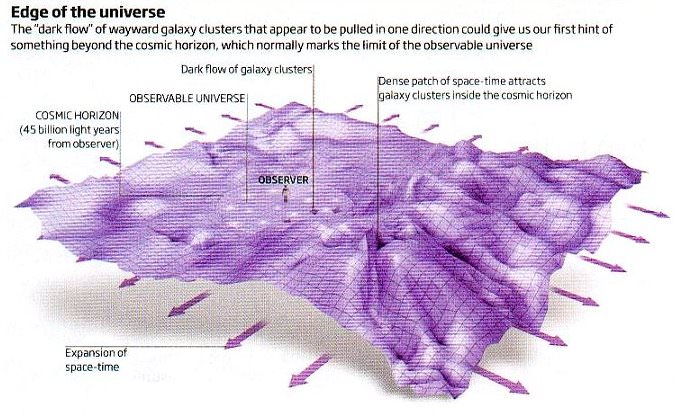

El hipotético "flujo oscuro" visto en el movimiento de los cúmulos de galaxias requiere que podamos identificar de forma fiable una clara correlación estadística en el movimiento de los objetos distantes los cuales están, en todo caso, fluyendo hacia el exterior con la expansión del universo y también pueden tener su propios movimientos individuales ( o particulares) que surgen de las interacciones gravitacionales.

Por ejemplo, aunque las galaxias tienen una tendencia general a alejarse unas de las otras cuando el espacio-tiempo se expande entre ellas, la Vía Láctea y la Galaxia de Andrómeda están actualmente en curso de colisión unidas gravitacionalmente.

Por lo tanto, si usted está interesado en el movimiento del universo a gran escala, lo mejor es estudiar el flujo a granel o flujo masivo– donde usted retrocede en su consideración de objetos individuales y en su lugar busca tendencias generales en la propuesta de un gran número de objetos.

la ilustración muestra la hipótesis del "flujo oscuro".Una región del universo observable está siendo influenciada por alguna cosa misteriosa a las afuera del universo observable .Crédito.universe-review.ca.

el aparente "flujo oscuro" irregular (entre las constelaciones de Centauro y La Vela) es alegado de ser el responsable del movimiento aparente de varios cúmulos galácticos mostrados en la imágen donde el rojo representa el más distante y el azul el menos distante.Esto sugeriría de que alguna cosa más alla del universo observable ha permanecido allí desde que el universo era muy jóven.Credito: Kashlinsky, NASA.

Observaciones a muy grandes escalas del movimiento de los cúmulos de galaxias fueron propuestas por Alexander Kashlinsky (ver aquí) en el 2008 para indicar una región de flujo irregular, incompatible con la tendencia general en el movimiento y la velocidad esperados para la expansión del universo - y que no se pueden explicar por localizadas interacciones gravitacionales.

Sobre la base de estos hallazgos, Kashlinsky ha propuesto que inhomogeneidades en el universo primitivo pueden haber existido antes de la inflación cósmica - lo que representaría una violación del actualmente favorecido modelo estándar para la evolución del universo, conocido como el Lambda Cold Dark Matter ( Lambda CDM).

El irregular flujo masivo podría resultar de la existencia de una gran concentración de masa más allá del borde del universo observable - o, tal vez sea otro universo adyacente. Dado que se desconoce la causa –( y como no se sabe, si la causa está más allá de nuestro horizonte observable )- la astronómica 'oscuridad' es invocada- originándose el término “flujo oscuro”.

Para ser justos, muchas de las sugerencias de "ahí afuera" para tener en cuenta estos datos la hacen los comentaristas de Kashlinsky, en lugar de Kashlinsky y sus colegas investigadores en sí mismos - y esto incluye el uso del término “flujo oscuro”. Sin embargo, si los datos de Kashlinsky no son sólidos como una roca, toda esta especulación salvaje se vuelve un poco redundante - y la navaja de Occam sugiere que se debe seguir asumiendo que el universo se explica mejor por el actual modelo estándar Lambda CDM.

La interpretación de Kashlinsky tiene sus críticos. Por ejemplo De-Chang Dai (ver aquí) ha proporcionado una evaluación reciente del flujo masivo basada en las velocidades individuales (peculiares) de las supernovas de tipo 1A.

El análisis de Kashlinsky se basa en las observaciones del efecto Sunyaev-Zel'dovich - que implica distorsiones débiles en elfondo de microondas cósmico (CMB) que resultan de la interacción de los fotones del CMB con electrones de alta energía - y estas observaciones sólo se consideran útiles para identificar y observar el comportamiento de las estructuras de gran escala tales como cúmulos de galaxias. De-Chang Dai en su lugar utiliza específicos puntos de datos –las observaciones de las candelas estándar las supernovas Tipo 1a - y observa el ajuste estadístico de estos datos a la espera de observar el flujo masivo del universo.

Así, mientras que Kashlinsky dice que debemos ignorar el movimiento individual de las unidades y basta con observar el flujo global o masivo- Dai dice que debemos buscar en el movimiento de las unidades individuales y determinar qué tan bien los datos se ajustan a el flujo masivo supuesto.

Resulta que Dai encuentra que los datos de las supernovas pueden adecuarse a la tendencia general del flujo masivo propuesto por Kashlinsky - pero sólo en las más cercanas regiones (de bajo corrimiento hacia el rojo). Más significativamente, no son capaces de replicar cualquier velocidad irregular. Kashlinsky midió un irregular flujo masivo de más de 600 kilómetros por segundo, mientras que Dai encontró velocidades derivadas de las observaciones de las supernovas tipo 1A que se adaptan mejor a un flujo masivo de sólo 188 kilómetros por segundo. Este es un ajuste que cuadra con el flujo masivo esperado del modelo Lambda CDM del universo en expansión, que es de alrededor de 170 kilómetros por segundo.

fuente de la información:

http://www.universetoday.com/84227/astronomy-without-a-telescope-dark-statistics/

Hace 30 años, un informe en la revista Physical Review D transformó totalmente el pensamiento científico sobre el origen del universo.

Las nuevas ideas de la física de partículas, que el documento mostró, implicaban que el universo podría haber sido objeto de una fase de expansión muy rápida en las primeras fracciones de segundo de su existencia. Este episodio inflacionario, como fué llamado, podría explicar cómo nuestro universo llegó a tener su densidad observada y uniformidad. La inflación no sólo se convirtió en uno de los principios centrales de la teoría cosmológica, sino que también significó que cualquier aspirante a teórico cósmico tuviera que aprender sobre la física de partículas.

En la década de 1970, los teóricos de partículas comenzaron a construir las grandes teorías unificadas (GUTs), las cuales proponen que a las temperaturas o las energías superiores a unos 1015 mil millones de electrón-voltios (GeV), la fuerza electromagnética y las fuerzas nucleares débil y fuerte son idénticas. En el modelo estándar del Big Bang, el cosmos comenzó lo suficientemente caliente como para alcanzar ese estado de gran unificación. Entonces, a una edad cósmica de unos 10-35 segundos, la fuerza nuclear fuerte se separó de la fuerza electrodébil todavía unificada. Los teóricos se dieron cuenta de que una consecuencia no deseada de esta transición , es que se crearía una gran cantidad de monópolos magnéticos - un fenómeno incompatible con las observaciones cósmicas.

el telescopio espacial James Webb observará el universo infrarojo después de su lanzamiento en el 2014 o más tarde.Entre sus tareas estará el observar la luz desde la temprana historia cósmica y probar el concepto de la inflación,una expansión exponencial del universo durante su infancia la cual fué originalmente propuesta en 1981.Crédito.Nasa.

Dos problemas aparentemente sin relación también existen en la cosmología de la época. En primer lugar, el problema de la uniformidad: el universo se ha expandido tan rápidamente que no ha habido tiempo para que todas las regiones del universo observable hoy en día igualen sus temperaturas y densidades mediante el intercambio de materia y energía. ¿Por qué, entonces, el universo parece más o menos el mismo en todas partes?

El segundo enigma es que nuestro universo parece ser aproximadamente "plano" - en las más grande escalas de distancia, elespacio-tiempo tiene poca o ninguna curvatura. Sin embargo, en el modelo cosmológico estándar, cualquier universo que comienza con un poco de curvatura, positiva o negativa, se aleja de la planitud a medida que el universo se expande. Un universo que es casi plano, después de más de diez mil millones de años es tan difícil de organizar como un lápiz que se mantenga en equilibrio sobre su punta por eones.

A finales de 1979, Alan Guth, , en el Centro del Acelerador Lineal de Stanford en California, se dió cuenta de que una solución al problema del monópolo en el cual había trabajado recientemente con un colega [ ver aquí ] también podría resolver estos dos importantes enigmas. La solución consistía en un ingrediente de las GUTs conocido como el campo de Higgs, el cual se supone que impregna todo el espacio. A medida que el Universo se expandió y se enfrió, la fuerza fuerte se separó de las demás cuando el campo de Higgs pasó de un valor a otro. Para resolver el problema del monópolo, Guth y Henry Tye, ambos de la Universidad de Cornell el año anterior, supusieron que el campo de Higgs no cambió inmediatamente, sino que quedó estancado por algún tiempo en el valor incorrecto. La situación era algo así como una bola que queda atrapada en una depresión en la cima de una colina, evitando que se desplace hasta el valle. Un retraso en la transición de Higgs significó una menor producción de monopolos magnéticos.

Guth empezó a preguntarse lo que el retraso de la transición significaría para la expansión cósmica. Cuando el campo de Higgs estaba atrapado en un valor incorrecto, se convirtió en la energía dominante en el universo, con la extraña propiedad de hacer que el universo se expandiera de manera exponencial con el tiempo, en contraste con la usual más lenta expansión para un universo lleno solamente de materia y radiación.

"La inflación", como Guth llamó a esta expansión exponencial, resuelve el problema de la uniformidad, ya que toma un pedazo de los inicios del universo lo suficientemente pequeño como para haber sido uniformizado por los procesos internos y lo disemina hasta una región mucho más grande la cual podemos ver hoy en día. También mostró que la inflación empuja al universo más cercano a una perfecta planitud cuanto más tiempo pasa.

En su documento, Guth admitió un grave problema con su modelo. El campo de Higgs no completa su transición en cada región del espacio, dejando un universo heterogéneo que no es como el universo que vemos. Sin embargo un año después otros científicos encontraron formas de ajustar la teoría y evitar este problema [ ver aquí y aquí].

Rocky Kolb, ahora en la Universidad de Chicago, dice que en el momento en que los físicos de partículas comenzaron a interesarse en la cosmología, el problema del monópolo parecía más urgente que los otros rompecabezas cósmico. "No teníamos la menor idea [de si la inflación] sería el concepto poderoso que resultó ser." Pero ahora, dice, la inflación es ubícua en la cosmología y promete explicar mucho más, incluyendo el origen de las estructuras, tales como galaxias y cúmulos de galaxias.

más información AQUÍ

fuente de la información:

http://focus.aps.org/story/v27/st12

En los sistemas de estrellas binarias que consisten en una estrella de neutrones y una menos evolucionada compañera, material rico en hidrógeno y helio puede transferirse a la superficie de la estrella de neutrones. Allí, se comprime y se calienta a temperaturas extremadamente altas que facilitan el desboque termonuclear.

(Los desboques son accionados por la energía liberada en la reacción nuclear triple alfa y otras reacciones nucleares que "estallan" desde el llamado caliente ciclo de carbono-nitrógeno-oxígeno (CNO)[ más información aquí ].) Las explosiones se conocen como ]estallidos de rayos X tipo I, ya que lanzan un gran flujo de rayos X que se detectan como un fuerte aumento de la luminosidad de rayos X, seguida de un decaimiento más lento.

La mayor parte de la energía de las explosiones proviene de una serie de reacciones nucleares que ocurren tras de lo que se llama el proceso de captura rápida de protones (o, proceso rp): Los protones se fusionan con los núcleos semillas en rápida sucesión, sintetizando isótopos en un camino en zigzag de fusión de protones y desintegraciones beta inversas, cerca de la línea de goteo de los protones, están los límites de la existencia nuclear más allá del cual los núcleos simplemente no puede envolver a otro protón. Al final de dicha explosión, quedan los núcleos en camino de desintegración y una población de núcleos hacia la línea de estabilidad. El proceso rp así aumenta la abundancia de elementos específicos en las cenizas de la superficie de la estrella de neutrones, e incluso determina algunas de las propiedades observacionales de las explosiones de rayos x, tales como el tamaño y la forma del perfil de luminosidad con el tiempo. Dado que la luminosidad se puede vincular a la masa de la estrella de neutrones, la comprensión de las reacciones nucleares que contribuyan a la ráfagas de rayos x es fundamental [ver aquí y aquí ]. Hay otra razón para estudiar el proceso rp: Si el material sintetizado durante un estallido de rayos-x se escapa del campo gravitatorio de la estrella de neutrones y se arroja en el medio interestelar, el podría potencialmente ser una fuente de elementos químicos específicos en la galaxia, cuyos orígenes son difíciles de explicar. Los ejemplos incluyen una serie de núcleos estables ricos en protones, como el molibdeno-92 o el rutenio 96.

Los esfuerzos para simular la trayectoria de la nucleosíntesis en el proceso rp y comprender la producción de estos isótopos dependen en gran medida de los datos de física nuclear, tales como las masas,-la vida media, y las tasas de captura de varios núcleos inestables. La masa, o más específicamente la energía de separación del protón (la energía que se necesita para remover un protón de un núcleo) desempeña un papel especialmente decisivo.En la actualidad, la incertidumbre en las masas determinadas experimentalmente de muchos núcleos inestables son significativas (en contraste, las predicciones teóricas para las masas de los núcleos estables son muy buenas). Sin embargo, la mejora de las medidas para los núcleos cercas de las líneas de goteo de protones, los más importantes para el proceso de rp es difícil. Las simulaciones de la producción de trayectorias zigzag se modifican de acuerdo a las masas asumidas (energías de separación), la predicción de la abundancia final varía hasta en un orden de magnitud entre los cálculos.

en la parte superior de la imágen se muestra una ilustración artística de una estrella de neutrones en acreción en un sistema binario,isótopos ricos en protones altamente inestables son producidos en estallidos de rayos x a través de un proceso llamado rp.Estos isótopos inestables posteriormente se desintegran en más isótopos estables y podrían ser la fuente de algunos isótopos raros sobre la Tierra.En la parte inferior de la imágen se muestra un posible proceso rp en la región de la carta nuclear donde el grupo SHIPTRAP llevó a cabo sus mediciones.El balance (entre la captura radiactiva del protón (p,γ) donde la energía es liberada y la fotodisociación (γ,p) donde la energía es absorbida y un protón emitido, crea y destruye el Tecnecio-87 respectivamente) es altamente sensible a la masa nuclear involucrada.Las nuevas mediciones del SHIPTRAP de la masa del Tecnecio-87 y el molibdeno86 en particular muestran que la fotodisociación es relativamente fuerte lo suficiente para impedir el flujo de la reacción hacia arriba y favoreciéndo el proceso de desintegración beta en la región núclear con A=86.Credito: (Top) NASA/Dana Berry; (Bottom).

Uno de los objetivos principales de la trampa de iones SHIPTRAP, ubicado en el Centro Helmholtz GSI de Investigación de Iones Pesados en Darmstadt, Alemania, es el de mejorar las mediciones de masa de los núcleos inestables que participan en el proceso de rp . En un artículo que aparece en la revista Physical Review Letters [ ver AQUÍ], un equipo internacional de científicos que trabajan en el SHIPTRAP informan de mediciones de masa ,algunas de las cuales son las primeras de isótopos ricos en protones en las proximidades de la masa atómica (A) 84 ( ver Fig. parte inferior). Esta región se encuentra alrededor del molibdeno 84- un llamado punto nuclear de espera, porque es un núcleo donde la radiactiva captura de protones compite con la reacción de fotodisociación inversa, y el flujo "hacia arriba" en la tabla nuclear se detiene en esencia, favoreciendo en cambio un lento proceso de desintegración beta. Mejores mediciones de masa en esta región podrían ayudar a predecir la cantidad de energía producida en ciertos caminos de los procesos rp, y a su vez, qué tan alto puede ser una temperatura alcanzada en un estallido de rayos-x. Esto a su vez determina qué elementos se podrían producir, por ejemplo,en un ciclo denominado ZrNb-un ciclo que toma un estado nuclear excitado a través de una serie de capturas y desintegraciones para volver a su punto de partida y tiene el efecto de la inhibición de la nucleosíntesis hasta las más altas masas.

El corazón de los experimentos en el SHIPTRAP es una trampa de iones(Penning) un espectrómetro de masas el cuál es el instrumento más preciso y exacto para determinar la masa de los isótopos de corta vida. Las trampas Penning son hoy en día el caballo de batalla para las mediciones de masa de precisión, y son empleadas en casi todas las instalaciones donde se producen vigas raras . En estas trampas de iones (por lo cual se le dio el premio Nobel de 1989 a Hans Dehmelt y Wolfgang Paul) la frecuencia de ciclotrón (ν) con la cuál las partículas cargadas orbitan en un campo eléctrico y magnético combinado es medido, y de aquí su masa es derivada (a través de ν=m/q*B).Las trampas Penning han sido técnicamente avanzadas para permitir experimentos en casi todos los isótopos raros disponibles, desde isótopos de muy corta vida como el litio 11, que tiene una vida media de 8 ms [ ver aquí ] a elementos super pesados [ ver aquí ], que se producen en cantidades minúsculas de unos pocos iones por minuto o menos.

El equipo SHIPTRAP midió las masas de diez núcleos deficientes en neutrones , que se produjeron en una reacción de fusión-evaporación en el filtro de velocidad GSI SHIP (una fuente única para los núcleos relevantes). El filtro separó los productos fugaces de la reacción y el haz de los productos restantes se detiene en una celda de gas. A partir de ahí, los iones son extraídos y entregados al sistema de trampa de iones donde las masas se determinarán con una precisión relativa de δm/m~10-7 a 10-8, o alrededor de 5 to 15 keV de incertidumbre absoluta (una unidad de masa atómica es de aproximadamente 1 GeV). El equipo encuentra bajas energías de separación alfa (la energía requerida para remover una partícula alfa del núcleo) en comparación con lo que se había predicho y que se había encontrado en estos núcleos previamente. Y con estos valores de masa exacta de los núcleos, el equipo está en condiciones de realizar una reevaluación del paisaje de masa dentro de una región específica de la carta nuclear. Obtienen una imagen homogénea de las masas, sin los saltos o brechas artificiales que resultan de las masas no medidas. En base a sus datos, recalculan un proceso rp similar a lo que se espera en un estallido de rayos x en un escenario estelar. Ellos encuentran que una vez que se incluyen sus nuevos valores de masa, la producción resultante en el número de masa A = 86 se cambia por un factor 20, el cambio más grande jamás encontrado en el cálculo de un proceso rp, una vez que los nuevos resultados experimentales se han incluido. Este sorprendente resultado subraya la necesidad de alta calidad en los datos de física nuclear.

Curiosamente, mediciones similares de masa realizadas en el new Cooler Storage Ring en la Instalación de Investigación de Iones Pesados en Lanzhou, China, muestran que la energía de separación de protones medida del arsénico-65 difiere de las predicciones teóricas. Los autores también ponen en duda la expectativa de que el germanio-64 es un núcleo de punto de espera. Aunque sus medidas son menos precisas que los métodos con la trampa Penning realizados en el GSI, los resultados de este equipo están llevando también a nuevas conclusiones sobre los procesos rp .

El equipo SHIPTRAP observa también un cambio del paisaje de masa hacia los núcleos más ricos en protones, en el que los protones están más débilmente ligado. El proceso rp parece favorecer este camino y conduce a un cambio en la abundancia de los isótopos restantes con A = 86 y los progenitores indirectos del isótopo clave molibdeno-94 (10% de molibdeno). Por otra parte, su recién descubierta baja energía de separación alfa sugiere que el ciclo de producción ZrNb se ve favorecido, lo que permitirá poner un límite a la disponibilidad de temperatura y energía en el proceso de rp. Para profundizar en esto y poner mayores restricciones sobre tales posibilidades, más mediciones directas de masas, en particular para el zirbonium-80, circonio-81, niobio-83, y por supuesto del molibdeno-84, son necesarias ya que desempeñan un papel clave en la comprensión del proceso rp y el alcance y los límites de la producción de elementos de tal escenario.

Entender la nucleosíntesis y los energéticos estallidos de rayos X requiere un enfoque interdisciplinario entre las observaciones astronómicas, los modelos de astrofísica y cálculos, y una buena comprensión de la física nuclear subyacente. Este trabajo muestra la sorprendente visión que proceden de mediciones de precisión de unas pocas (pero claves) propiedades de la física nuclear.

fuente de la información:

http://physics.aps.org/articles/v4/24