Las luminosas radio galaxias, por supuesto, también contienen estrellas. La relación entre el desarrollo de las estrellas de una radio galaxia y su agujero negro nuclear sigue siendo muy incierto. Los astrónomos del CfA Steve Willner y Giovanni Fazio, junto con nueve colegas, usaron el Telescopio Espacial Spitzer y sus cámaras infrarrojas para estudiar el polvo caliente y brillante en el infrarrojos de una gran muestra de setenta radio galaxias cuya luz ha estado viajando hacia la Tierra por tiempos que van desde 7.5 hasta 12 mil millones de años - las épocas cósmica donde la mayoría de los astrónomos piensan que la maduración de las galaxias ocurrió.

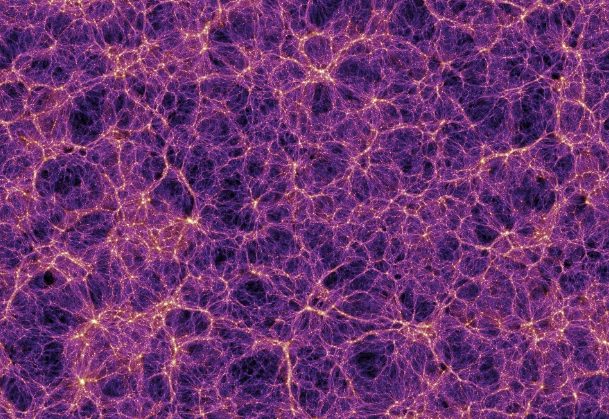

radio imágen en falso color de la relativamente cercana radio galaxia Centaurus A mostrándo la emisión de lóbulos gigantes de radio (en violeta) la galaxia principal y su núcleo están localizados en el centro el cuadro inserto muestra una imágen en multiples longitudes de onda incluyendo la luz visible de la misma galaxia,un nuevo estudio hecho en el infrarojo sobre 70 radio galaxias parecidas a Centaurus A encontró que 4 poseían evidencia de tener 2 agujeros negros en sus núcleos lo que sugiere que las radiogalaxias probablemente se forman mediante la fusión de galaxias más pequeñas.Crédito.Ilana Feain, Tim Cornwell & Ron Ekers (CSIRO/ATNF). ATCA northern middle lobe pointing courtesy R. Morganti (ASTRON), Parkes data courtesy N. Junkes (MPIfR).

Los astrónomos informan que la mayoría de estas galaxias completaron el proceso de hacer la mayoría de sus estrellas cuando el universo tenía sólo unos 2.5 mil millones de años. También encontraron que las diferencias en la emisión infrarroja de la muestra es consistente con la idea de que sus núcleos activos están oscurecidos por discos de polvo siendo observados en varios ángulos. El equipo llegó a una notable conclusión. Cuatro de las setenta galaxias muestran evidencia en las imágenes de un segundo agujero negro súper masivo, lo que sugiere que el origen de estas galaxias (y quizás también el de las otras durante alguna etapa anterior de desarrollo) fue causado por la fusión de dos galaxias más pequeñas.

En otro artículo en la misma edición de la revista Astrophysical Journal, los astrónomos teóricos del CfA Yue Shen y Avi Loeb presentan un análisis de la firma espectral de la radiación de los agujeros negros binarios. Si los agujeros negros están en realidad orbitando uno alrededor del otro en lugar de sólo estar de cerca el uno del otro, y suponiendo que cada uno tiene un medio ambiente de acreción emitiendo luz, los científicos demuestran que la pruebas de diagnóstico de ese movimiento estarán presentes en la forma de las líneas espectrales emitidas - al menos cuando los dos agujeros negro están orbitando bastante de cerca. El resultado, aunque no específicamente aplicado a las galaxias luminosas de radio con agujeros negros binarios, ofrece una nueva forma de sondear los detalles de la actividad de los agujeros negros en los núcleos de las galaxias.

fuente de la información:

http://www.cfa.harvard.edu/news/2010/su201049.html