Solíamos pensar que comprendíamos a los protones, pero estos pilares del núcleo atómico podrían enviar nuestras teorías de la física de partículas hacia abajo.

En la vida larga de un protón, 10 años es solo un instante. Estas partículas estables sin par,que son la base del núcleo atómico, no son propensas a la decadencia y la descomposición de algunos de sus hermanos subatómicos. La medición de su vida media al observar muchos de ellos aporta poco por un tiempo muy largo.Nuestra mejor estimación actual es que sobreviven por más de 1029 años - más de mil millones de mil millones de veces la edad del universo.

Diez años, sin embargo, es lo que le tomó a Randolph Pohl y sus colegas para mostrar que el protón no es todo lo que parece. Los resultados de sus experimentos en el Instituto Paul Scherrer (PSI) en Villigen, Suiza, se publicaron en julio del año pasado. El protón no se había convertido de repente en menos estable. Sino que el era un poco más pequeño de lo que la teoría y experimentos anteriores permitían .

protones y neutrones en el núcleo atómico .Crédito Dorling Kindersley/Getty.

En el mundo hiperpreciso de la física subatómica, se trataba de dinamita. Una tormenta de fuego de debates y contradebates fué lo que siguió. Pero con la más simple explicación de la discrepancia que ahora acaba de encontrarse, parece que la disminución misteriosa del protón ha abierto un hueco fundamental en nuestra comprensión de lo que hace que los átomos existan. ¿Qué ocurre?

Todo lo referente a los protones, y de todas las partículas cargadas, es tratado por una teoría llamada electrodinámica cuánticao QED. Una de las facetas de la naturaleza que describe es la fuerza electromagnética, por ejemplo, cómo las idas y venidas de los fotones de luz mantienen a los electrones cargados negativamente orbitándo a los protones cargados positivamente y así hace que los átomos sean posibles. Más profundo en el núcleo atómico se encuentra el campo de una teoría compañera , lacromodinámica cuántica o QCD, la cuál describe cómo los protones son un conjunto de partículas más pequeñas - los quarks - y los gluones (los cuales unen a estos quarks). Juntas,la QED y QCD son los dos pilares de los físicos de partículas " orgullosos del logro, de su" modelo estándar ".

La vida interior de los protones es conocida por ser oscura e impenetrable . Aparentemente, sin embargo, todo parece dulzura y luz. Tome el radio del protón, cuyo valor aceptado se ha resuelto usando dos tipos diferentes de medición. La primera un enfoque directo es disparar electrones en la dirección general de los protones, como los perdigones de goma que se disparan a un pato de feria. Al medir en qué momento comienzan a rebotar, podemos tener una idea de donde los electrones encuentran a la carga difusa de los protones.

Travesuras del Muón.

El segundo método consiste en medir los niveles de energía orbital del electrón girando alrededor del protón central de un átomo de hidrógeno estándar. Los niveles de energía pueden ser introducidos en los cálculos de la QED para determinar hasta qué punto la carga de los protones se debe extender para mantener a los electrones en las órbitas.

Los resultados de estos dos enfoques están en buen acuerdo.El promedio que ellos dan del radio del protón es de 0.877 femtómetros, o una fracción en una billonésima de un milímetro.

Y así todo iba bien, hasta que Pohl y sus colegas se propusieron en la década de 1990 determinar el radio del protón usando un tercer, supuestamente más preciso método. Ellos crearon átomos parecidos al hidrógeno-en el que los electrones se sustituían por muones. Estas partículas tienen la misma carga negativa que los electrones, pero son unas 200 veces más pesados. Eso significa que orbitan 200 veces más cerca que la órbita de los electrones, dándo una más cercana y personal idea de lo grande que es el protón.

Las mediciones de los niveles de energía orbital de los muones significaban primero adivinar las diferencias entre los dos niveles de interés, por lo que un láser podría ser sintonizado en la frecuencia correcta para volcar un muón de un nivel a otro. El equipo hizo esto invirtiendo las ecuaciones de la QED y fijando el valor aceptado para el radio del protón para dar un punto de partida estimada.

En los primeros intentos de realizar el experimento completo, en el 2003 y 2007, ese enfoque no funcionó: los muones no respondieron. Fué sólo en el 2009, cuando el equipo tuvo un nuevo láser que podría llegar a frecuencias más altas, encontrando in situ a los muones y los persuadieron a saltar. La introducción de los niveles de energía determinados experimentalmente se usaron de nuevo en el cálculo QED lo cuál produjo la sorpresa. El error en el radio del protón se había reducido en un factor de 10, como se esperaba - pero el radio se había reducido también en 0.8418 femtometres, se trataba de un 4 por ciento inferior a la media anterior (veraquí).

Cuatro por ciento no puede sonar mucho, pero en la QED, donde la teoría y la experimentación están de acuerdo en una parte o dos en un mil millones, esto era una vergüenza enorme. Y no había un error evidente en la medición. "Tuvimos que tomar la discrepancia en serio", dice Michael Distler de la Universidad de Mainz, Alemania.

Sólo unas semanas más tarde, Distler y sus colegas enturbiaron la trama aún más. Publicaron una medida del radio del protón con el probado método de la dispersión de electrones que no sólo duplica su exactitud, sino que trae su valor perfectamente en línea con aquel de medir los cambios en el nivel de energía del hidrógeno ordinario (ver aquí).El experimento de muones, el cual debería haber sido el más preciso, fué extraño por fuera. Pero ¿por qué?

Una propuesta inicial fué que el protón está rodeado por un halo grande y difuso de carga positiva, es decir, el electrón en órbita distante y el muón en una órbita más cercana "ven"a los protones de diferentes tamaños . Ese modelo parece haber sido descartado, ya que hacía otras predicciones que están en desacuerdo con los mejorados experimentos de dispersión de electrones. Ahora la atención se ha desplazado a posibles fallas más fundamentales:como el que podríamos haber pasado por alto las sutilezas en el funcionamiento de la QED, o que a la QED le falta algo.

La primera posibilidad se deriva del hecho de que, de acuerdo con la QED, dos partículas cargadas orbitándo entre sí intercambiarán fotones. Cuanto más fuerte sea el vínculo entre las partículas, más energía tendrá estos fotones. Si la energía sobrepasa una marca determinada, un fotón puede subir la apuesta y brevemente convertirse en una partícula y su antipartícula - un electrón y un positrón, por ejemplo - antes de volver a ser un fotón de nuevo.

Debido a que un vínculo más fuerte es necesario para que un protón refrene al más masivo muón, hay más margen para este tipo de cosas en el hidrógeno muónico. La idea es que una espesa nube de efímeras partículas y antipartículas protegen la órbita del muón de algunos de los efectos atractivos del protón, lo que reduce el radio efectivo del protón .

Suena plausible, pero hay un problema: encontrar un par partícula-antipartícula que produzca exactamente la cantidad correcta de protección. Para ello sería necesario que la pareja tenga una masa combinada de alrededor de 46 megaelectronvolts (MeV) - mucho más que un par electrón-positrón, que pesa poco más de 1 MeV, pero muy por debajo de los más de 200 MeV necesarios para un par muón-antimuón .

Para Ulrich Jentschura, un físico de la Universidad de Missouri de Ciencia y la Tecnología en Rolla, eso hace las cosas difíciles."La teoría tiene un problema incluso inventando una partícula que podría explicar la discrepancia sin enredar algo más arriba," él dice.Él y otros han estado analizando la posibilidad de que una nueva partícula desde un "sector oculto" del modelo estándar pudiera estar escondida. Hasta ahora, sin embargo,no han encontrado nada que alteraría los resultados experimentales establecidos en el hidrógeno normal (ver aquí y aquí).

Una de las propuestas del grupo de Mainz es que el culpable es un veloz emparejamiento de un quark y un antiquark. Eso es controvertido. Los quarks y sus antipartículas sólo se sabe que se unen en el interior de partículas como el protón, donde son cargados con un montón de equipaje de gluones. La más ligera asociación conocida quark-antiquark, el pión, inclina las escalas a 140 MeV.Los investigadores piensan que los pares de quark-antiquark vinculados podrían aparecer y desaparecer tan rápidamente que no recogerían la carga completa de gluones (ver aquí). En ese caso, podrían ser más ligeros.

No todo el mundo está convencido. Krzysztof Pachucki de la Universidad de Varsovia en Polonia está de acuerdo en que la QED puede enlazar con la QCD de quarks y gluones para producir interacciones imprevistas o subestimadas- pero señala que esperaríamos ver los efectos en otros experimentos.

Eso deja la posibilidad de que hay una mancha en la QED en sí misma.Son pocos los físicos que creen que ello es probable, dada la precisión superlativa de la teoría en casi todas sus predicciones. Aun así, los teóricos han revisado las ecuaciones pertinentes por una señal de algo que falta. "Hasta ahora, nada lo suficientemente grande como para explicar una diferencia del 4 por ciento la cual parece dejarse ver", dice Paul Indelicato, un teórico del Laboratorio Kastler Brossel en París, Francia, quien formó parte del equipo de hidrógeno muónico PSI.

Mona Lisa con bigotes.

Alexander Kholmetskii de la Universidad Estatal de Belarús en Minsk y sus colegas creen que tienen algo. El problema radica, según ellos, con la ecuación - la ecuación de Dirac - que fué la primera piedra de la QED y se utiliza para describir los estados de energía de las partículas tales como electrones o muones en órbita en un átomo. Hay dos componentes de esta ecuación, una describiendo cómo las partículas envuelven energía tras la unión de ellas mismas al núcleo con fotones, y una describiendo cómo ellas pueden perder la energía mediante la radiación de fotones a distancia.

En el más bajo estado orbital de energía, los investigadores plantean, que este tipo de pérdida de radiación no es posible, por lo que aplican una pequeña corrección. Incorporándo esto en los cálculos del radio del protón deja el valor medido utilizando muones prácticamente sin cambios, mientras el movimiento del electrón resulta casi perfecto de acuerdo con ello (ver aquí ) Exactamente la misma corrección resuelve un problema similar de niveles de energía en el positronio, un "átomo" en el que un electrón y un positrón órbitan uno del otro.

Esta explicación, sin embargo, ha dejado la mayoría de los pelos de punta. La ecuación de Dirac es ampliamente festejada como una de las más bellas, ecuaciones concisas en toda la física. Hacer correcciones sobre ella es, para muchos físicos, similar a garabatear un bigote a la Mona Lisa. "No hay necesidad de recurrir a cualquier cosa que hagan para explicar las propiedades de radiación de los átomos", dice Indelicato. El hecho de que el nivel de energía más bajo no puede entregar energía ya está integrado en la QED, dice.

Todo lo que nos deja en un callejón sin salida, sin ninguna explicación para obtener la aprobación universal. "Hay documentos que pretenden explicar, pero están equivocados", dice Pachucki.

Con la teoría en un punto muerto, la atención se centra ahora en una nueva ronda de experimentos. Hemos medido el radio del protón por disparos de electrones en él, y mediante la medición de los niveles de energía de los electrones y muones en órbita. Podrían disparar muones hacia él para traer una idea nueva? Si estos misiles muón ven un protón de diferentes tamaños, entonces debe haber algo fundamentalmente diferente en la forma en que los muones interactúan, como por ejemplo la participación de nuevas partículas o parejas de partículas que no habíamos pensado. Y si no lo hacen, dice Jentschura, entonces estás realmente atascado. "Entonces la discrepancia actual parecería aún más interesante y extraña", dice.

Mientras tanto Pohl, Indelicato y sus colegas están comenzando a hacer mediciones en el deuterio muónico. Este núcleo de un átomo exótico, que consiste en un protón y un neutrón, también se puede utilizar para calcular el radio del protón. Tal vez otra década podría llevarnos a una respuesta definitiva.

Todos en una vuelta

Mientras el debate sobre el tamaño del protón ha hecho más que estallar , las entrañas de la partícula han sido un enigma para nosotros por mucho tiempo- en concreto desde 1988, cuando los investigadores en el CERN cerca de Ginebra, Suiza, descubrieron que no podían explicar el spin del protón.

El spin es una propiedad cuántica de una partícula similar a una rotación sobre su propio eje. Las partículas de diferentes spin responden a los campos magnéticos de diferentes maneras, por lo que es una cosa relativamente fácil de medir. El protón, por ejemplo, tiene un spin de ½.

Este spin debe de alguna manera proceder de la rotación de los componentes del protón, al igual que el protón es una unidad de carga positiva que viene de sumar la carga de los tres quark "de valencia" dentro de el, dos de carga +2 / 3 y uno de carga -1 / 3.

Al disparar protones separados, con muones de alta energía, el European Muon Collaboration del CERN logró medir el spin de los quarks en el interior del protón. Encontraron que podrían ser responsable de sólo una cuarta parte del spin esperado (veraquí). Experimentos posteriores han elevado esa proporción un poco, pero confirmaron el resultado básico.

Esta "crisis de spin" ha sido la fuente de grandes rascadura de cabeza desde entonces. "Pensábamos que entendíamos la estructura cuántica de un protón, pero en el fondo no lo hacemos," dice Robert Jaffe, un teórico en el Instituto de Tecnología de Massachusetts.

Lo ideal sería resolver la crisis mediante la solución de las ecuaciones de la cromodinámica cuántica (QCD), la teoría que gobierna las interacciones dentro del protón. Sin embargo, estas resultan ser monstruosamente difíciles para una partícula con tantos elementos móviles como el protón - no sólo los quarks de valencia, sino los gluones que los unen y un "mar" de otros quarks y gluones efímeros que, de acuerdo a las normas sin consecuencias de la física cuántica brevemente aparecerán de la nada y desaparecerán otra vez. Estas complicaciones también abruman a los intentos de utilizar supercomputadoras para simular el origen de spin del protón.

Así que nos quedamos con experimentos desordenados para llenar los vacíos. Una sugerencia es que los gluones podrían llevar una proporción sustancial de spin del protón. Medida que directamente es difícil, pero experimentos en marcha en el CERN y en otros lugares indican que las contribuciones son cercanas a cero.

Entonces existe la posibilidad de que el spin del protón tenga menos que ver con los spin de los quarks y los gluones en forma individual y más que ver con la forma en que se orbitan entre sí. Hasta ahora sólo tenemos vagas ideas de cómo podemos ir sobre la medición de eso.

El resultado es un estancamiento. "Básicamente estamos esperando que algún joven inteligente pueda llegar con una idea brillante", dice Jaffe.

¿Por qué nos importa? En primer lugar, dice Jaffe, porque todos estamos compuestos de protones y neutrones y nos gustaría saber cómo funcionamos. Para los físicos, sin embargo, aún hay más en juego. Si hay tal cosa como una teoría del todo, esperamos que se parezca mucho a la QCD, sólo que sería más difícil. Si no podemos entender lo que sucede dentro del humilde protón, se desvanecerían las esperanzas de que alguna vez seríamos capaces de conseguir controlar esa la más grande teoría.

fuente de la información:

http://www.newscientist.com/article/mg20928051.600-proton-puzzle-trouble-at-the-heart-of-the-atom.html

Mediante la creación de condiciones parecidas a las del espacio en un delgado recipiente de 4m, los investigadores italianos han ayudado a confirmar el comportamiento de los chorros astrofísicos - corrientes de partículas cargadas que salen disparadas por agujeros negros supermasivos y estrellas jóvenes, los cuales se extienden varios cientos de miles de años luz a través del espacio.

montaje experimental.

Las corrientes de partículas inicialmente cargadas - conocidas como chorros astrofísicos - los cuales pueden viajar a velocidades cercanas a las de la luz hasta ahora sólo habían sido entendidas por medio de simulaciones por ordenador, pero ahora están siendo reproducidas en los vacíos producidos en el laboratorio.

La investigación publicada en New Journal of Physics describe cómo los investigadores italianos han creado, condiciones parecidas a la del espacio en un recipiente con el fin de utilizar una cámara de acción rápida para confirmar el comportamiento de los chorros.

Estos chorros , los cuales se originan en los puntos centrales de las galaxias, están entre los objetos más grandes del universo y se asocian generalmente con los discos de materia comprimida, que en espiral orbitan objetos como estrellas o agujeros negros, de forma parecida al agua en espiral en un desague.

Para crear, en parte, las condiciones extraterrestres en el laboratorio, los investigadores del Politécnico de Turín, el Politecnico de Milano, Universidad de Torino y el Instituto Max Planck en Goettingen diseñaron un recipiente cilindrico vacío de 4m de largo.

Trás comprimir y bombear gases como el helio, argón, xenón y el aire normal, los investigadores fueron capaces de dar a los gases la energía necesaria para impulsarlos en el vacío del recipiente el cual es parecido al espacio.

Hacia el final del recipiente de 4m, los gases fueron bombardeados con electrones, los cuales excitaron los átomos y los hicieron visibles, por lo tanto permitiendo que fueran capturados por una cámara de acción rápida.

Los investigadores encontraron que en la vida real los chorros astrofísicos se comportan en su intermedio y lejano campo de una manera que están bien representada por la dinámica newtoniana. Este comportamiento es capturado por las simulaciones por ordenador en 3-D, lo que confirma el éxito de las simulaciones en 3-D para nuestra comprensión del comportamiento intergaláctico.

El profesor Daniel Tordella, del Departamento de Ingeniería Aeronáutica,del Politecnico de Torino, dijo: "En la ciencia moderna, la prueba experimental de laboratorio es el último paso ya que permite una comprensión firme y profunda de la fenomenología..

"En el presente caso , es un medio económico de la investigación en comparación con las observaciones del telescopio espacial. Siempre que sea posible, creemos que las investigaciones de los laboratorios de la tierra deben acompañar la actividad de observación."

leer el estudio AQUÍ

fuente de la información:

http://www.physorg.com/news/2011-04-space-jets-bottle.html

Los físicos de Harvard han ampliado las posibilidades de la ingeniería cuántica de nuevos materiales tales como superconductores de alta temperatura tras persuadir a los átomos ultrafríos atrapados en una red óptica - un cristal de luz – a auto-organizarse en un imán, utilizando sólo diminutas perturbaciones resultantes de la mecánica cuántica. La investigación, publicada en la revista Nature, es la primera demostración de un "imán cuántico" en una red óptica.

A medida que la tecnología moderna depende cada vez más y más de los materiales con propiedades mecánico cuánticas exóticas, los investigadores se encuentran con una barrera natural.

"El problema es que lo que hace a estos materiales útiles es a menudo lo que los hace muy difícil de diseñarlos", dijo el autor principal, Markus Greiner, un profesor asociado en el Departamento de Física de la Universidad de Harvard. "Pueden entrelazarse , existiendo en múltiples configuraciones a la vez. Esta característica de la mecánica cuántica es difícil de representar por computadores normales, así que tuvimos que tomar otro enfoque. "

los físicos prepararon una cadena de imánes de un solo átomo(esferas rojas con flechas negras que indican la orientación norte-sur) los cuales se repelen entre sí y están alineados con un campo externo ( fila de atrás) .Al reducir el campo pudieron observar la reorientación( fila delantera)causada por la repulsión magnética(hélice amarilla) y las diminutas fluctuaciones cuánticas .El fondo de la imágen muestra los imánes individuales(puntos azules) cada uno compuesto por un solo átomo,tal como se observan en el experimento.

Este enfoque está utilizando el llamado "simulador cuántico" - las propiedades de un material cuántico se simulan con un sistema cuántico artificial que puede comportarse de manera similar, pero que es más fácil de manipular y observar.

Los físicos descubrieron que cuando se aplica una fuerza a un cristal formado por átomos ultrafríos atrapados en una red óptica , un aislador de Mott, los átomos se comportaban como una cadena de pequeños imanes que se repelían entre sí, en presencia de un campo magnético externo que buscaba alinearlos.

"Cuando el campo magnético externo era fuerte, todos los imanes se alinearon con él, formando un paramagneto", dijo el coautor Jonathan Simon, un becario postdoctoral en física. "Cuando redujimos el campo magnético , los imanes de forma espontánea se anti-alinearon con sus vecinos, produciéndo un antiferromagneto ".

Si bien esta auto-organización es común en los materiales de uso cotidiano, por lo general se depende de la temperatura para empujar al sistema al nuevo orden, parecido a sacudir unjuego de Boggle para ayudar a ordenar los dados, dicen los investigadores. "Pero la temperatura era tan baja que las fluctuaciones térmicas estuvieron ausentes", explicó Simon. "Nuestra fluctuaciones surgieron de la mecánica cuántica."

Cuando la mecánica cuántica se hace cargo, las cosas se ponen extrañas."Las fluctuaciones cuánticas pueden hacer que los imanes apunten en varias direcciones al mismo tiempo", dijo Greiner. "Esta 'rareza cuántica" da a lugar a muchas de las fascinantes propiedades de los imanes cuánticos ".

Greiner y sus colegas usaron un microscopio de gases cuánticos para observar imanes individuales a temperaturas de una mil millonésima de grado sobre el cero absoluto (-273 grados Celsius). Ellos fueron capaces de ver como las fluctuaciones cuánticas se volcaron alrededor de los imanes, girando un paramagneto en un antiferromagneto y viceversa.

"La observación del magnetismo cuántico en un gas frío es un primer paso crucial hacia la simulación cuántica de los materiales magnéticos reales", dijo Greiner."Quedan muchas preguntas interesantes que responder, y sólo hemos arañado la superficie. Mediante el estudio de la forma extraña y maravillosa en que la mecánica cuántica funciona, abrimos nuevas perspectivas no sólo para el desarrollo de nuevos materiales de alta tecnología, sino también para el procesamiento de información cuántica y computación. "

leer el estudio AQUÍ

fuente de la información:

http://www.physorg.com/news/2011-04-quantum-magnet-physicists-prospects-unusual.html

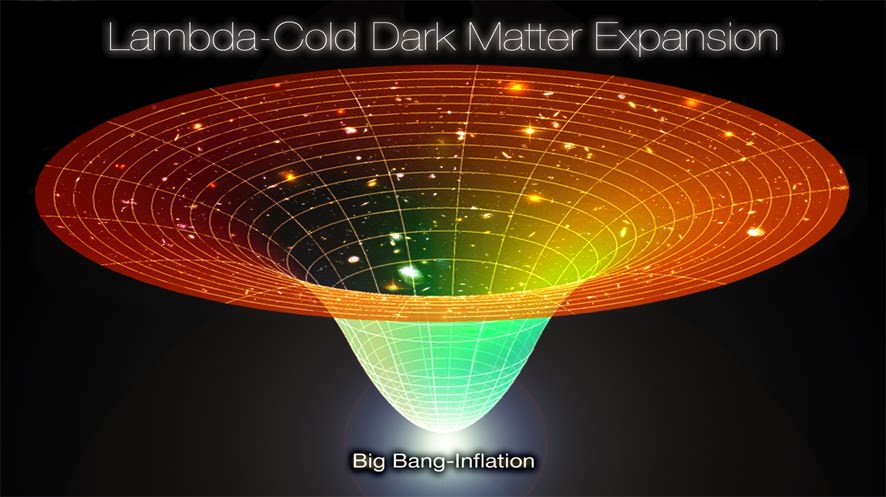

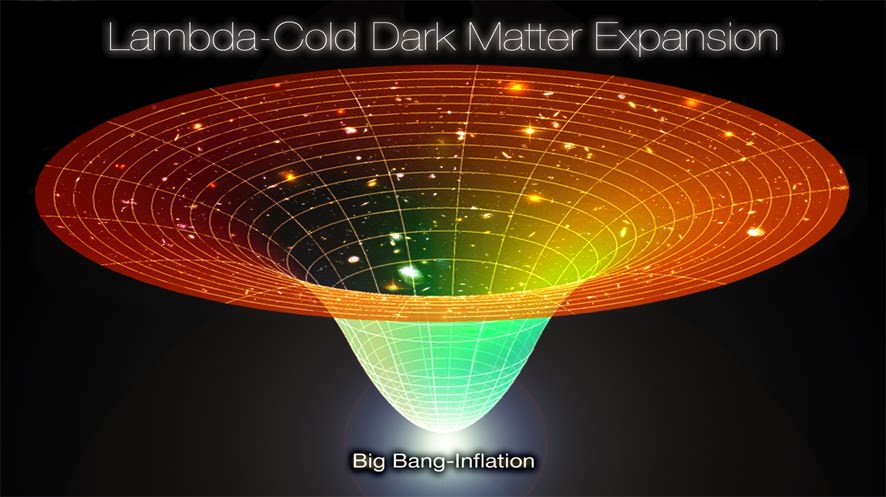

El actual modelo estándar del universo, Lambda-Cold Dark Matter, supone que el universo se está expandiéndo de acuerdo con el término geométrico Lambda – el cual representa la constante cosmológica utilizada en la relatividad general de Einstein.

Lambda podría ser asumida de representar la energía oscura, una misteriosa fuerza que conduce lo que ahora sabemos es una expansión acelerada del espacio-tiempo. La materia oscura fría entonces se supone proporciona el andamiaje que sustenta la distribución de la materia visible a gran escala en todo el universo.

Pero para hacer cualquier intento razonable de modelar como el universo es - y la forma en que se desarrolló en el pasado y se desarrollará en el futuro -, en primer lugar tenemos que asumir que es más o menos igual en todas partes.

Esto es a veces llamado el principio cosmológico que dice que cuando se ve en una escala lo suficientemente grande, las propiedades del Universo son las mismas para todos los observadores. Esto refleja dos conceptos – el de isotropía, que significa que el universo se ve más o menos igual en cualquier lugar que usted observe - y la homogeneidad, la cual significa que las propiedades del universo lucen más o menos iguales para todos los observadores que estén en cualquier lugar y en cualquier lugar que miren. La homogeneidad no es algo que podemos esperar confirmar siempre por la observación - por lo que debemos suponer que la parte del universo que podemos observar directamente es una muestra justa y representativa del resto del universo.

el modelo Lambda-CDM intenta describir el universo entero trás asumir que el universo en su totalidad es isótropo y homo géneo.Esta hipótesis asi mismo se aplica al pasado ,presente y futuro incorporando un simple origen en el evento del BigBang,una actual geometría plana y un futuro dominado por la aceleración de la expansión aquí y en cualquier parte.Crédito .Sourced from: coldcreation.blogspot.com.

usted ocupa una posición en el espacio-tiempo desde la cuál una proporción del universo puede ser observado en su cono de luz pasado.Usted puede asi mismo dirigir el haz brillante de una antorcha hacia adelante a una parte del universo futuro,conociéndo que un día ese haz de luz puede alcanzar un objeto que permanece en su cono de luz futuro .Sin embargo usted no puede conocer alrededor de cosas que sucedan ahora mismo en una distante posición en el espacio debido a que ellos permanecen sobre la hipersuperficie del presente.Credito: Aainsqatsi.

Una evaluación de la isotropía es por lo menos teóricamente posible bajo nuestro cono de luz del pasado. En otras palabras, miramos hacia el universo y recibimos información histórica acerca de cómo se comportó en el pasado. A continuación, asumimos que aquellas partes del universo que podemos observar han continuado comportándose de una manera consistente y predecible hasta la actualidad - a pesar de que no podemos confirmar si esto es verdad hasta que más tiempo ha pasado. Pero cualquier cosa fuera de nuestro cono de luz es algo de lo cual nunca podremos esperar conocer sobre ella y por lo tanto sólo podemos asumir que el universo es homogéneo en todas partes.

Roy Maartens ha venido desarrollando un argumento de por qué podría ser razonable para nosotros el asumir de que el universo es homogéneo. En esencia, si el universo que podemos observar muestra un nivel consistente de isotropía con el tiempo, esto sugiere que nuestra parte del universo se ha desarrollado de una manera consistente con ser una parte de un universo homogéneo.

La isotropía del universo observable puede estar fuertemente implícita si usted busca en cualquier dirección y encuentra:

• consistencia de la distribución de la materia;

• consistencia de velocidades de la mayor parte de las galaxias y cúmulos de galaxias que se alejan de nosotros a través de la expansión universal.

• consistencia de las mediciones de distancia de diámetro angular (donde los objetos del mismo tamaño absoluto se ven más pequeños a una distancia mayor - hasta una distancia de desplazamiento al rojo de 1.5, cuando empiezan a observarse más grandes - ver aquí ), y

• consistencia del efecto de lente gravitacional para los objetos a gran escala como cúmulos galácticos.

Estas observaciones apoyan la hipótesis de que tanto la distribución de la materia y la geometría subyacente del espacio-tiempo del universo observable es isotrópica. Si esta isotropía es cierta para todos los observadores entonces el universo es consistente con la métrica de Friedmann-Lemaître-Robertson-Walker (FLRW) . Esto significaría que es homogéneo, isotrópico y conectado – así usted pueda viajar a cualquier parte (simplemente conectado) - o él puede tener agujeros de gusano(multiplemente conectados) por lo que no sólo se puede viajar a cualquier parte, sino que hay atajos.

Esos observables del universo han sido siempre isotrópicos - y es probable que continúen siéndolo así en el futuro – esto es fuertemente apoyado por las observaciones del fondo cósmico de microondas ,el cuál es isotrópico a una escala fina. Si esta misma isotropía es visible para todos los observadores -, entonces es probable que el universo, es y será siempre homogéneo,también.

Por último, Maartens apela al Principio Copernicano - que dice que no sólo no estamos en el centro del universo, sino que nuestra posición es en gran medida arbitraria. En otras palabras, la parte del universo que podemos observar bien puede ser una muestra justa y representativa del universo en general.

autor de la nota el astrónomo STEVE NERLICH para Universe Today.

más información AQUÍ

fuente de la información:

http://www.universetoday.com/84730/astronomy-without-a-telescope-assumptions/

En 1998, los científicos descubrieron que el Universo se está expandiéndo a un ritmo acelerado. En la actualidad, la explicación más ampliamente aceptada para esta observación es la presencia de una energía oscura no identificada, aunque otras posibilidades se han propuesto.

Una de estas alternativas es que algún tipo de gravedad repulsiva - o antigravedad - está empujando el universo a separarse.Como muestra un estudio reciente, la relatividad general predice que la interacción gravitatoria entre la materia y laantimateria es mutuamente repulsiva, y podría explicar la expansión observada del universo sin necesidad de energía oscura.

Desde que la antimateria fue descubierta en 1932, los científicos han estado investigando si su comportamiento gravitacional es atractivo - como la materia normal - o repulsivo. Aunque las partículas de antimateria tienen la carga eléctrica opuesta de sus partículas de materia asociadas, las masas de las partículas de la antimateria y la materia son exactamente iguales. Lo más importante,es que las masas son siempre positivas. Por esta razón, la mayoría de los físicos piensan que el comportamiento gravitatorio de la antimateria debería ser siempre atractivo, como lo es para la materia. Sin embargo, la cuestión de si la interacción gravitatoria entre la materia y la antimateria es atractiva o repulsiva hasta el momento no tiene respuesta clara.

En el nuevo estudio, Massimo Villata del Observatorio Astronómico de Turín (Observatorio de Turín) en Pino Torinese, Italia, ha demostrado que una respuesta se puede encontrar en la teoría de la relatividad general. Como explica Villata, la actual formulación de la relatividad general predice que la materia y la antimateria son auto-atractiva, sin embargo, la materia y la antimateria se repelen mutuamente. A diferencia de las propuestas de antigravedad anteriores - como la idea de que la antimateria es gravitatoriamente auto-repulsiva –La propuesta de Villata no requiere cambios a las teorías bien establecidas. El estudio se publica en una edición reciente del EPL ( Europhysics Letters ).

la imágen muestra la constitución de los átomos de hidrógeno y anti-hidrógeno,un nuevo estudio indica que la gravedad actuaría de manera repulsiva entre la materia y la antimateria lo que podría explicar el concepto de energía oscura utilizado para describir la aceleración en la expansión del universo.Crédito.Experiment AEGIS.

"La importancia de este estudio es en realidad doble", dijo Villata. "Por un lado, el de la física en general, por haber demostrado que uno de los conceptos más heréticos debatidos en los últimos decenios, es decir, el de antigravedad, se puede encontrar como una predicción de la unión de dos de las mejores teorías establecidas del siglo pasado, proporcionándo la extensión de la relatividad general a la antimateria, considerándola como materia que invierte el espacio-tiempo, según lo requerido por la simetría CPT. Por otro lado, las implicaciones cosmológicas de esta investigación han demostrado a la antigravedad como una alternativa (o explicación) del concepto borroso de la energía oscura para la expansión acelerada del Universo . "

Al principio, la idea de la gravedad repulsiva entre la materia y la antimateria parece ir en contra de la intuición, dado que nosotros usualmente consideramos a la masa de ser el único componente que determina el comportamiento gravitatorio de un objeto.Pero, como explica Villata, no es sólo la masa la que participa en la gravedad sino en este caso, el tiempo y la paridad están también involucrados.

La idea se basa en el concepto de que todas las leyes físicas tienen simetría CPT (carga, paridad y tiempo) .La simetría CPT significa que, con el fin de transformar un sistema físico de materia en un sistema equivalente de antimateria (o viceversa), descrito por las mismas leyes físicas, no sólo deben ser reemplazadas las partículas por su correspondiente antipartícula (operación C), sino una transformación adicional PT también es necesaria.

Desde esta perspectiva, la antimateria se puede ver como materia normal que ha sufrido una transformación completa CPT, en la cual su carga, paridad y tiempo son todos invertidos . A pesar de que el componente de carga no afecta a la gravedad, la paridad y el tiempo afectan a la gravedad mediante la inversión de su signo. Así, aunque la antimateria tiene masa positiva, puede ser considerada como que tiene masa gravitatoria negativa, ya que la carga gravitacional en la ecuación de movimiento de la relatividad general no es simplemente la masa, sino que incluye un factor que es sensible a la PT y produce el cambio de signo.

Como explica Villata, la simetría CPT significa básicamente que la antimateria existe en un espacio-tiempo invertido (la operación P invierte el espacio, y la operación T invierte el tiempo). El da la siguiente analogía: si una anti-manzana cae sobre la cabeza de un anti-Newton sentado sobre una anti-Tierra, ella caería exactamente de la misma manera como si todos estos objetos estuvieran hechos de materia normal. Pero si una anti-manzana cae sobre la Tierra (normal), o una manzana (normal) cae sobre una anti-Tierra, entonces el resultado es diferente. En ambos casos, un signo menos emerge en la ecuación de movimiento, el cual invierte la interacción gravitatoria entre la anti-manzana y la Tierra, o la manzana y la anti-Tierra, por lo que es repulsiva.

La predicción teórica de la antigravedad entre la materia y la antimateria podría tener consecuencias significativas, si es verdad. Siempre que la materia y la antimateria se encuentran, se aniquilan y producen fotones. Pero si la materia y la antimateria se repelen entre sí, entonces ellas tenderían a aislarse la una de la otra y no aniquilarse. La fuerza de esta repulsión de materia-antimateria podría explicar por qué el Universo se está expandiéndo a un ritmo acelerado, lo que elimina la necesidad de energía oscura y, posiblemente,de la materia oscura.

Villata sospecha que la antimateria podría existir en el Universo en grandes escalas de vacío que se han observado en la distribución de los cúmulos de galaxias y supercúmulos. Estudios previos han encontrado que estos vacíos se pueden originar a partir de pequeñas fluctuaciones negativas en la densidad del campo primordial, la cuales repelen a la materia circundante - como si tuvieran una masa gravitatoria negativa. Con diámetros de decenas de megaparsecs (alrededor de un centenar de millones de años luz), estos vacíos son las más grandes estructuras del Universo. El problema es que, hasta ahora, los investigadores no han observado la antimateria en estos lugares. Villata planea investigar esta cuestión en un próximo estudio sobre la invisibilidad de la antimateria en los vacíos.

"Las ideas relevantes están ahí, pero estoy buscando la mejor manera de formalizarlas", dijo. "Sin embargo, usted puede encontrar anticipaciones sobre esto y muchas otras características de la materia viajando atrás en el tiempo en la novela de Max Wells (que es mi seudónimo literario, en honor de JC Maxwell y HG Wells), La Flecha oscura del tiempo, que está actualmente publicada sólo en italiano (La freccia oscura del tempo), pero espero encontrar una edición en inglés pronto. "

Como para probar la posibilidad de la antigravedad entre materia y antimateria, el próximo experimento AEGIS en el CERN podría proporcionar algunas respuestas.El experimento comparará como la gravedad de la Tierra afecta a los átomos de hidrógeno y antihidrógeno, y podría dar a los científicos una mejor comprensión de las propiedades gravitacionales de la antimateria.

"La antigravedad siempre ha sido polémica, y probablemente seguirá siendo así hasta que podamos obtener una respuesta experimental (o de observación) ", dijo Villata. "Sin embargo, espero que mi trabajo, mientras tanto, pueda por lo menos disipar algunos prejuicios en contra de la antigravedad."

leer el estudio AQUÍ

fuente de la información:

http://www.physorg.com/news/2011-04-antimatter-gravity-universe-expansion.html

Los telescopios de hoy no pueden mirar lo suficientemente lejos en el pasado cósmico para observar la formación de estrellas primordiales. Si usted quiere ver este proceso, se necesitan sofisticadas simulaciones numéricas.

Alrededor de 400 000 años después del Big Bang, el universo era lo suficientemente frío que los electrones y protones podrían unirse para formar hidrógeno neutro. A través del estudio de la radiación del fondo cósmico de microondas, los cosmólogos han obtenido una excelente comprensión del estado del universo en la época de la "recombinación". En el momento en que el universo tenía 1 mil millones de años, contenía pequeñas galaxias, explosiones de rayos gamma, e incluso brillantes quásaresprobablemente energizados por agujeros negros supermasivos más pesados que un mil millones de soles. A partir de observaciones de tales objetos, los astrónomos han recogido más información sobre el universo primitivo.

Pero la mayoría de los primeros mil millones de años de la historia cósmica han sido inaccesible a la observación directa. Los cosmólogos llaman a ese período temprano la edad de las tinieblas y especulan sobre la naturaleza de los primeros objetos en el universo y su papel en la conformación de lo que iba a seguir. Que se formó primero los agujeros negros o las galaxias? Que se formó primero las estrellas de gran masa o de baja masa? En cuales estrellas se forjaron los primeros núcleos de carbón y oxígeno y distribuidos en el espacio intergaláctico, un requisito previo necesario para la formación de estrellas que se asemejan a las de la Vía Láctea? ¿Podrían algunas de las primeras estrellas estar todavía presentes hoy?Cuando los átomos de hidrógeno fueron ionizado, y de dónde provino la energía para hacer eso? Esas son sólo algunas de las cuestiones más acuciantes que muchos cosmólogos teorizan sobre, y parcialmente , en previsión de una nueva generación de telescopios que empezarán a dar respuestas en los próximos 10 años (más información aquí y aquí).

la materia oscura une al gas.

Desde el fondo cósmico de microondas y otras observaciones, los cosmólogos han reconstruido una imagen convincente y detallada de los inicios del universo. A los pocos minutos del Big Bang, el universo tuvo un 76% de todo su gas en forma de hidrógeno ionizado y el 24% como helio ionizado, una composición elemental que se mantuvo sin cambios hasta que se formaron las primeras estrellas. También estuvieron presentes rastros de deuterio, berilio y litio, que en conjunto contribuyeron con menos de 1/10 000 de la densidad de masa cósmica.Durante esa época, la distribución de material era casi perfectamente uniforme a través del espacio. Las desviaciones pequeñas probablemente provenían de las fluctuaciones cuánticas que crecieron exponencialmente durante el periodo de inflación cósmica.

Después de la recombinación, casi todo el hidrógeno era neutral, y sólo 2 de cada 10 000 protones y electrones no estaban consolidados. Por lo tanto, esencialmente toda la radiación remanente de los primeros tiempos viajó libremente, es decir, sin la dispersión de electrones. El fondo cósmico de microondas es un registro de esa radiación, que desde entonces ha viajado por 13.7 mil millones años de trayectoria recta a nuestros detectores.

El pequeño número de electrones libres era suficiente para que la dispersión Compton fotón-electrón,acoplara la temperatura de la radiación a la del gas. Los electrones calentados podrían colisionar con protones, o bien podrían intercambiar posiciones con un electrón en un átomo de hidrógeno neutro. Como resultado, la temperatura de iones y la temperatura del gas neutro se acoplaron también. Aquellos mecanismos para acoplar termalmente la radiación y el gas primordial fueron efectivos hasta que el universo tenía aproximadamente 10 millones de años. A partir de entonces, la expansión del universo enfrió el gas más rápido de lo que el efecto Compton podría calentarlo.En consecuencia, el gas podría haber alcanzado temperaturas tan bajas como unos pocos Kelvin antes de que cualquier estructura se formara en el universo. A temperaturas tan bajas, y con densidades de sólo de alrededor de 100 partículas por metro cúbico, la presión del gas era pequeña. Mientras tanto, los objetos de materia oscura se estaban formando jerárquicamente, los pequeños colapsaron primero y continuamente se acrecionaron y se unieron para hacer objetos de mayor tamaño. El gas se acumuló en los potenciales pozos de grumos de materia oscura, tan pronto como la atracción gravitacional de las masas superó a las bajas fuerzas de presión del gas.

figura nº 1 ; los cuadros en la parte superior de la imágen muestran la densidad (donde el rojo indica menos denso y el amarillo más denso) y los cuadros de la parte inferior muestran la temperatura(donde el rojo indica 10K y el amarillo 1000K)del perfil del gas que cae hacia adentro del potencial gravitacional de la materia oscura.a)Se observa aquí un evidente choque en la acreción(azul en la parte alta y amarillo en la parte baja) que irradia desde el gas recogido por la masa de materia oscura ,el gas que subsequentemente cae adentro convertirá su energía cinética a energía térmica interna cuando el pase el choque, el trabajo presión-volumen asi mismo calienta el gas .La región mostrada tiene un espesor de 10000 años luz b)Una vez que el gas obtiene una temperatura suficientemente alta el hidrógeno molecular se forma, la región aquí mostrada tiene un ancho de 1000 años luz correspondiéndo el amarillo a una temperatura de 1000K .c)El decaimiento molecular enfría el gas el cual se reúne en el centro, el área mostrada aquí tiene 15 años luz de ancho e incluye alrededor de 1000 masas solares de gas, el rango de temperatura va desde los 100K a 1000K.Cuando el centro de la concentrada nube molecular se contrae bajo su propia gravedad ella produce una densa región en al menos dos órdenes de magnitud más pequeño de lo mostrado aquí ,eso es responsable de la formación de estrellas.Crédito. . (Simulation by Matthew Turk and Tom Abel; image by Tom Abel.)

Pero procesos adicionales debieron tener lugar antes de que las estrellas y los agujeros negros se pudieran formar en los halos dominado por la materia oscura, los cuales tienen masas de alrededor de 10 000 masas solares (M⊙) y una característicaenergía potencial gravitatoria (el término técnico es "la temperatura virial" ) del orden de unos pocos cientos de grados Kelvin. El gas atrapado constantemente se reordena el mismo, tratando de alcanzar un equilibrio estable, equilibrando sus fuerzas de presión interna en contra de la atracción gravitatoria hacia el interior de la materia oscura. Cuando el gas sigue cayendo hacia el interior, choques de acreción se forman a unos pocos cientos de años-luz del centro de la masa (véase la figura 1a). El gas que cae, acelerado por la fuerza gravitacional, cuando pasa aquellos choques convierte su energía cinética en energía térmica interna,. Bultos comienzan a fusionarse, y cuando lo hacen, tanto la masa y la temperatura virial del objeto proto-galáctico resultante se incrementan.

Con el tiempo, la temperatura llega a ser lo suficientemente alta que las reacciones químicas, cambian la composición del gas. En esa temprana etapa, uno de los procesos químicos más importante es catalizado por la pequeña fracción de electrones libres restos de la recombinación, un evento que se llevó a cabo varias decenas de millones a 100 millones de años antes. Los electrones se unen al hidrógeno neutral para formar el frágil ión de hidrógeno negativo. El ión luego rápidamente se une a un átomo de hidrógeno neutro, formando una molécula de hidrógeno y expulsándo el electrón catalítico.La Figura 1b muestra el objeto de materia oscura y gas en esa etapa.

Incluso una sola molécula por cada 1000 átomos neutros conduce a un cambio dramático en el comportamiento termodinámico del gas. Eso es porque el nivel más bajo de energía rotacional de la molécula de hidrógeno tiene una energía de excitación de sólo 512 K, lo suficientemente bajo para el nivel (y también superiores) en el que se excita cuando la molécula choca con suficientemente rápidos átomos de hidrógeno neutro. Con un tiempo de desintegración de cientos de años, la molécula diatómica es un emisor pobre. Pero también es pobre en absorción. Así, cualquier fotón liberado del decaimiento de un nivel rotacional o vibracional de la molécula saldrá del objeto proto-galáctico. Puesto que la energía de escape del fotón se toma del movimiento del átomo de hidrógeno neutro en colisión, el proceso de emisión se lleva parte de la energía interna del gas y lo enfría. Con el enfriamiento disminuye la presión. Las fuerzas gravitatorias contraen más el gas, el cual se acumula en el centro de las estructuras dominadas por la materia oscura (ver la figura 1c).

La contracción disminuye una vez que el gas alcanza una densidad crítica de 105 partículas/cm3, que corresponde a una temperatura de unos 200 K. En esa concentración crítica el hidrógeno molecular cambia su comportamiento de refrigeración. Para el gas por debajo de la densidad crítica, cada colisión conduce a la emisión de un fotón, mientra más denso el gas se vuelve, más rápido se enfría. , Sin embargo una vez que la densidad crítica es superada, las tasas para excitar los niveles rotacional y vibracional de la molécula se vuelven mayores que las tasas de decaimiento radiactivo. Ya no es el caso de que cada excitación por colisión produce un fotón, sino que la emisión de fotones por cada molécula tiende a un valor constante y la escala de tiempo característica para irradiar la energía interna se mantiene aproximadamente constante.

No sólo la física del H2 determina una densidad característica y temperatura para el gas cósmico,sino que también fija la longitud característica y escalas de masas. He aquí cómo: La temperatura ajusta la velocidad del sonido, la velocidad en la que los cambios en la presión de la nube puede ser comunicada. La densidad establece el tiempo de colapso gravitatorio de la región. La longitud característica, o la longitud de Jeans, es la distancia para la cual el tiempo de propagación del sonido será igual al tiempo de colapso gravitatorio. Es el apellido del físico Inglés James Jeans (1877-1946), quién la derivó de forma más rigurosa a través de un análisis de la estabilidad de las ecuaciones linealizadas de la hidrodinámica, con la gravedad incluida. Cuando la escala de un objeto es mayor que la longitud de Jeans, la gravedad domina sobre las fuerzas de presión interna. La longitud y la densidad en conjunto, determinan una escala masiva. Las consideraciones anteriores sugieren que cuando las masas de gas contenidas en los centros de los halos de materia oscura comienzan a contraerse debido a su propia gravedad, el gas tiene una masa característica de 100M⊙(cien masas solares).

Una nube molecular a plenitud.

Un poco más de la física y la química se convierten en relevante cuando la parte central de la nube de gas se contrae más allá.Cabe destacar que, una vez que la densidad ha llegado a cerca de 108 partículas/cm3, las colisiones de tres cuerpos de hidrógeno neutro pueden volver al material colapsándo en totalmente molecular. La energía de enlace emitida en la formación molecular es importante, y la mayor parte va a calentar el gas a temperaturas superiores a 1000 K.

La ahora completa nube molecular comienza a atrapar la radiación emitida por sus moléculas constituyentes. En consecuencia, se hace cada vez más difícil para enfriar el material por la excitación de los niveles rotacional o vibracional y la expulsión de fotones. De hecho, una vez que la densidad se eleva a 1012 partículas/cm3, la radiación emitida en el interior de la nube puede dispersarse y ser convertida en calor a través de colisiones de-excitación entre los átomos de hidrógeno o H2 y otras moléculas de H2. La masa de Jeans correspondiente al encendido de estos procesos es de aproximadamente 1 M⊙. Sin embargo, las mismas colisiones que calientan el gas también amplían las líneas espectrales y permiten la emisión inducida por la colisión con una mucho mayor cobertura espectral. Esa ampliación aumenta sustancialmente la eficiencia de enfriamiento del gas una vez que su densidad ha alcanzado 1015 partículas/cm3, que corresponde a una masa de Jeans de aproximadamente 0.01 M⊙. La contracción del gas más allá finalmente hace que se vuelva, ópticamente grueso a su propia radiación de refrigeración, por definición, se ha formado la protoestrella inicial. Durante esa fase de contracción, toda la radiación producida proviene de la energía potencial gravitatoria adquirida en la contracción. Por ahora, aproximadamente 100 millones de años después del Big Bang, las escalas de tiempo típicas se han reducido a minutos, pero la acreción continúa por otros 100 000 años, tiempo durante el cual la protoestrella se hincha a decenas de masas solares.

La comprensión de la formación de los primeros objetos luminosos debe involucrar a una gran cantidad de física, incluyendo la expansión cósmica, la gravedad, la dinámica de la materia oscura, hidrodinámica, química no equilibrada, y los procesos de radiación. Las simulaciones numéricas que incorporan toda esa física son intrínsecamente tridimensionales. Por otra parte, las simulaciones requieren un rango dinámico extraordinario: la más pequeña resolución espacial de elementos y el intervalo del tiempo son minúsculos en comparación con el tamaño del volumen de la simulación y el tiempo total desarrollado en el cálculo.

A mediados de la década de 1990, Greg Bryan y Michael Norman, ambos entonces en el Centro Nacional para Aplicaciones de Supercomputación de la Universidad de Illinois en Urbana-Champaign, implementaron un código numérico llamado Enzo , el primer código cosmológico en utilizar una técnica de refinamiento de red o malla de adaptación (ver aquí). La técnica no era nueva en sí misma, la ingeniería y la literatura aerodinámica de la década de 1980 incluye las discusiones sobre redes de adaptación, pero la aplicación a la formación de las primeras estrellas requirió un mucho mayor rango dinámico (ver aquí, aquíy aquí).Las simulaciones empleando una red adaptativa comienzan con una tan grande caja de cómputo como posible y periódicas sean las condiciones de contorno. La computadora almacena cantidades hidrodinámicas como la densidad, la energía interna por gramo, las velocidades, y composiciones químicas. Las ecuaciones relevantes son emitidas en forma comóvil de modo que la expansión cósmica es absorbida en las coordenadas; el material se transporta en la red de cómputo una sola vez su movimiento empieza a diferir de la expansión media de lo que es inicialmente un universo casi homogéneo e isótropo.

Una vez que la gravedad induce a una cierta cantidad de materia a contraerse, la fuerza actuará para concentrar aún más el material.Para la materia oscura, sin embargo, el colapso gravitacional no puede continuar mucho porque la materia oscura no puede disipar su energía cinética. Como resultado, una masa de materia oscura alcanza un equilibrio dinámico y el colapso se detiene cuando la energía cinética que la masa gana de caer en su potencial gravitatorio es igual a la mitad de la magnitud de la energía potencial gravitatoria.

Por otro lado, el gas cósmico puede colapsar a escalas tan pequeñas como el radio de Schwarzschild, más pequeño que el tamaño inicial por un factor de quizás muchos billones . Computacionalmente, el colapso de longitud a través de muchos órdenes de magnitud es capturado con, las redes “niño” hechas de células cuyo tamaño es de 1/n de la red matriz circundante.(Normalmente, n = 2). La red “niño” engendra más progenie para crear una jerarquía en evolución de redes construidas de manera óptima para capturar la física del campo de densidad subyacente. La figura 2 muestra un intervalo de tiempo típicos en una simulación, con una jerarquía de redes superpuestas.

figura nº 2 ; con el refinamiento de red adaptativa una simulación numérica genera redes cada vez más pequeñas para capturar con presición la física de la contracción del gas cósmico cuando se vuelve más denso .La imágen corresponde a un tiempo de 200 millones de años después del BigBang y representa una región de 2000 años luz de ancho.Las brillantes áreas muestran donde la densidad del gas cósmico es más grande ,superpuesta sobre el marco de la simulación esta una jerarquía de redes.Las más pequeñas redes tienden a seguir a las regiones brillantes de alta densidad. Crédito.(Simulation by John Wise and Tom Abel; image by Ralf Kaehler and Tom Abel.).

Las redes en un determinado nivel de jerarquía no se superponen. Normalmente, los cálculos se ejecutan primero para redes padres, las cuales pasan sus variables de estado a sus redes “niño” como valores límites. Una vez que los valores límites se establecen , la simulación puede avanzar el intervalo de tiempo para todas las redes en un nivel determinado. Una consideración importante es dar cuenta de los flujos a través de fronteras y, en particular, para garantizar la conservación de la masa, impulso y energía que se mueven entre las redes padre y niño.

Más que movimiento.

A diferencia de las interacciones hidrodinámicas, la fuerza gravitacional no es local. Para la mayor de las redes, la correspondiente ecuación de Poisson se puede resolver de manera eficiente con las técnicas de transformación rápida de Fourier. Para las redes más finas, la rápida multired es lo mejor. Para manejar el componente de materia oscura, las simulaciones utilizan métodos de N-cuerpos, que han existido desde la década de 1960. Son convenientes para aplicar y hacer un trabajo excelente de respetar las leyes de conservación. La idea es representar el campo de densidad de materia oscura por distintas, gravitacionalmente interactúantes partículas con una bien definida posición y velocidad. La ecuación de Poisson es entonces resuelta en la red con las masas de gas y materia oscura como fuentes. El potencial gravitatorio resultante es diferenciado al producir las fuerzas gravitacionales que aceleran el gas y la materia oscura. Las aceleraciones calculadas, a su vez, determinan nuevas velocidades para las partículas y cómo deberían ser movidas para el próximo intervalo en el tiempo. El resultado es una nueva distribución de densidad, la que conduce a nuevas aceleraciones, velocidades y posiciones.

Queda por resolver un conjunto de ecuaciones diferenciales ordinarias que describen las reacciones químicas en el gas. La química es fundamental porque, como hemos visto, el hidrógeno molecular que se forma fuera del equilibrio domina las pérdidas de radiación del gas primordial. En principio, muchos cientos de reacciones podrían ser importantes, pero los estudios realizados durante muchos años han concluido que 20 (más o menos )reacciones clave son suficientes para captar la abundancia de las 12 especies que afectan principalmente a la historia térmica del gas (ver aquí y aquí). Estas especies son los protones, los electrones , los átomos neutrales de hidrógeno, helio y sus dos formas ionizadas, el deuterio, deuterio ionizado, HD, hidrógeno molecular, H2 ionizado, y el negativo ión de hidrógeno H−.

Muchas investigaciones se han llevado para extraordinariamente robustecer y precisar a los paquetes numéricos que resuelven las ecuaciones diferenciales ordinarias que describen la red de reacción química.Sin embargo, si la aplicación numérica a gran escala fuera a ser corrida con esas rutinas, la química dominaría el costo computacional de la simulación. Por lo tanto,muchas personas han considerado ventajoso la construcción de rutinas que están optimizadas para las simulaciones de las primeras estrellas, con esas rutinas, la química ocupa sólo una pequeña fracción del presupuesto computaciónal ( ver aquí).

El programa numérico descrito anteriormente se ha aplicado en Enzo, una versión de código abierto ahora mucho más expandida del código desarrollado originalmente por Bryan y Norman hace más de una década. Existen otras técnicas, en particular el enfoque de la hidrodinámica de partículas suavizadas (ver aquí). Hasta el momento, los resultados obtenidos con distintos métodos están en excelente acuerdo.

Las simulaciones numéricas modernas pueden seguir toda la física descrita anteriormente, hasta el momento en que las primeras protoestrella se forman . Revelan que el material frío en el cual las estrellas se formarán se encuentra en cantidades significativas sólo en el centro de los halos de materia oscura. El gas se mueve aproximadamente a la velocidad del sonido y está fuertemente concentrado hacia el centro; su densidad cae un poco más pronunciada que 1/r2. Una región de 100-M⊙(cien masas solares) en el centro se contrae más rápido que sus alrededores. Las primeras protoestrellas, con masas de alrededor de 0.01 M⊙, se forman en los centros de las regiones con relativa rapidez de contracción. Las primeras protoestrellas tenían decenas de radios solares (R⊙) en ancho lo cuál es bajo por más de 10 órdenes de magnitud que los radios de los halos de materia oscura en la que se forman. Las simulaciones muestran altas tasas de acreción , y los modelos de simetría esférica demuestran convincentemente que dentro de 100 años, las protoestrellas crecerán hasta tener una masa solar, confinada a una región de varios cientos de radios solares de ancho. En algunos casos, como se muestra en la figura 3, las simulaciones capturan la formación de sistemas de dos o tres estrellas.

figura nº 3 ; las dos regiones de formación estelar en esta simulación están separadas por solo unos pocos cientos de distancias tierra-sol.El sombreado indica la densidad de las regiones,las más brillantes son las más densas ,el tiempo es alrededor de 200 millones de años después del BigBang .Crédito. (Simulation by Matthew Turk, Brian O’Shea, and Tom Abel; image by Ralf Kaehler and Tom Abel.)

Parece probable que las proto-estrellas en acreción no serán capaces de detener el material que fluye desde el rápidamente colapsante macizo central y que, por consiguiente, las primeras estrellas que se forman van a ser muy masivas. Sin embargo, existen muchas incertidumbres acerca de la fase de acreción. Una dificultad fundamental que enfrenta a las actuales técnicas numéricas tiene que ver con el intervalo de tiempo Courant , es decir, el tiempo que tarda una onda sonora en cruzar un elemento de resolución espacial pequeña. A medida que la protoestrella se calienta, la velocidad de sonido puede llegar a cientos de kilómetros por segundo. El intervalo de tiempo Courant correspondientes a una resolución de, digamos, 0.01 R⊙ sería menos de un minuto. Para seguir 100 000 años de evolución de la protoestrella por consiguiente, requerirían 100 mil millones de intervalos de tiempo. Eso no es factible con la tecnología actual, no importa la preocupación de si los errores de los códigos actuales son lo suficientemente pequeños para dar resultados exactos después de miles de millones de intervalos de tiempo.

Cálculos exploratorios emplean las llamadas partículas –sumidero removiéndo el gas de la computación y sustituyéndo las partículas gravitando, por lo general de un tamaño fijo. Estos cálculos sugieren complejas dinámicas (ver aquí ).Los discos masivos que se forman alrededor de las primeras protoestrellas puede dividirse en múltiples fragmentos. La mayoría de los fragmentos se fusionan. Algunos pueden ser disparado fuera de la nube en contracción debido a las interacciones gravitacionales de los tres cuerpos. Con suerte, los astrónomos pueden encontrar algunos de esos fragmentos-ahora convertido en estrellas cuyas atmósferas tienen una composición primordial en nuestra propia Vía Láctea.

El enfoque de partícula-sumidero es indudablemente crudo y ad hoc, y no permite un análisis numérico cuidadoso o estudios de resolución que comprueben que la discreción inherente de las simulaciones numéricas no introduce errores. Un gran reto técnico para los que simulan los inicios del universo es diseñar mejores, más sólidos, y más precisos algoritmos.

Como hemos visto, las simulaciones sugieren que las estrellas masivas predominan entre los primeros objetos luminosos. Si es así, las implicaciones son muchas e interesantes. Las estrellas masivas tienden a ser brillante y caliente. Una estrella de 100-M⊙ de hidrógeno y helio, por ejemplo, tendría una temperatura superficial de 200 000 K, casi 40 veces mayor que la del sol. Su luminosidad sería un millón de veces la de Sol. En consecuencia, la producción de energía enorme de estrellas masivas es en gran medida en el UV y es lo suficientemente poderosa para fotoionizar el hidrógeno neutro que la rodea a miles de años luz. Los electrones no consolidados suelen llevarse una energía del orden de 10 eV, suficiente para calentar el plasma resultante a unos 10 000 K. La nebulosa resultante, conocida por los astrónomos como las regiones H II, se han presentado al público en algunas de las imágenes más espectaculares del Telescopio Espacial Hubble.

figura nº 4 ; las estrellas masivas son calientes e intensamente brillantes.La radiación que emiten ioniza el hidrógeno a miles de años luz y la presión asociada barre el material lejos de la estrella .En la simulación mostrada aquí una estrella brillante se encuentra aproximadamente en el centro del marco .A excepción de una pequeña región angular en su parte inferior derecha la estrella ha barrido en gran medida sus alrededores los cuales aparecen más oscuros en la imágen .Si la estrella es lo suficientemente masiva ella puede finalizar su vida como un agujero negro en un ambiente donde hay poca acreción.Crédito. (Simulación por John Wise y Abel Tom; imagen por Ralf Kaehler y Abel Tom.).

Asociada a la radiación ionizante de una estrella masiva primordial está un aumento de la presión que rechaza el material de los halos de materia oscura en 10 veces la velocidad de escape gravitacional. En consecuencia, como se muestra en la figura 4, dentro de unos pocos millones de años de haber nacido, las estrellas masivas han en gran medida evacuado sus lugares de nacimiento. Al final de la vida de la estrella, la densidad circundante puede ser tan baja como 0.1 a 1 particulas/cm3. Con esta baja densidad, si la estrella muere en una explosión de supernova, los elementos pesados que expulsa pueden viajar más de 1000 años-luz en el medio intergaláctico. La inexorable fuerza de gravedad recogerá el material en pequeñas regiones de formación estelar, la figura 5 muestra una imagen simulada.Durante los próximos mil millones de años, decenas de miles de esas regiones se unirán para formar la Vía Láctea. De hecho, hasta uno en un millar de átomos de carbono y oxígeno en nuestros cuerpos ahora se cree que se han producido en las primeras generaciones de estrellas masivas.

figura nº 5 ; las primeras supernovas impulsáron material a grandes distancias a través del medio intergaláctico .Interacciones gravitacionales hicieron que el material se reuniera en las galaxias .En esta simulación un número de pequeñas galaxias son visibles en amarillo.La mayor de ellas visible en la parte inferior derecha tiene una masa de solo 1/5000 la de la Vía Láctea.Cientos de regiones como las que se muestran aquí se combinarán en unos pocos millones de años para formar galaxias parecidas a la nuestra .Las áreas rojizas son regiones donde las estrellas no se han formado aún.Crédito. (Simulación de John Wise, Abel, Tom y Michael Norman, la imagen de Ralf Kaehler y Abel Tom.).

Las regiones ionizadas por las primeras estrellas masivas son en realidad más grande que las regiones que contaminan con elementos pesados. Y, en efecto, las simulaciones muestran estrellas de composición primordial siéndo formadas en las regiones ionizadas por estrellas cercanas que se habían formado antes. Esa preionizacion es de interés por al menos dos razones.Ella genera electrones que catalizan la formación fundamental de hidrógeno molecular, y modifican significativamente la dinámica de los gases de los objetos de formación estelar. Las simulaciones sugieren que las masas típicas de las estrellas que se forman en ambientes preionizados tienen masas de 10M⊙, algo menor que las anteriores, estrellas ionizantes (ver aquí y aquí).

Las más masivas de las primeras estrellas pueden colapsar en agujeros negros en lugar de explotar en supernovas. Debido a la baja densidad del material que rodea a aquellos agujeros negros, su crecimiento sería limitado por millones de años. Tales agujeros negros primigenios están probablemente todavía en órbita alrededor de nuestra propia galaxia.

Las simulaciones numéricas ab initio han aportado una imagen detallada de la primera época de formación de la estructura cósmica, y el progreso continúa a buen ritmo. La edad oscura del universo explorado en las simulaciones es, por desgracia, ahora no accesibles a la observación directa. Hoy en día grán número de cosmólogos están trabajando para hacer predicciones sobre los objetos que tienen más que un puñado de estrellas. El éxito le permitiría un mejor contacto con los fenómenos observables directamente. Una segunda línea de investigación es entender los efectos del medio ambiente y otras variables sobre las primeras galaxias. Y no menos importante es abordar los enormes desafíos de la verificación y validación de los modelos extraordinariamente detallados.

Una nueva generación de telescopios pronto podría arrojar algo de luz sobre el oscurantismo. Radiotelescopios de gran alcance como el internacional Atacama Large Millimeter Array, el Low Frequency Array, y otros pueden proporcionar información relevante en los próximos años. Ellos pueden estudiar el material eyectado por las primeras supernovas, ya que se incorpora en las primeras galaxias. Tal vez los radiotelescopios, incluso serán capaces de proporcionar información sobre el hidrógeno intergaláctico en sí, de un momento en que sólo una pocas galaxias existían.

El Telescopio Espacial James Webb, sucesor del telescopio espacial Hubble, observará a las primeras galaxias en el extremo-IR y podría proporcionar pistas notables. En longitudes de onda más corta, la información detallada puede provenir de varios telescopios muy grandes: el Telescopio Europeo Extremadamente Grande que, se espera, será construido en su momento, y elTelescopio de Treinta Metros y el Telescopio Gigante Magallanes programado para la construcción en los EE.UU.. Muchos estudios de la Vía Láctea y las galaxias cercanas están en busca de un "registro fósil" que limitaría lo que podría haber sucedido en los primeros 100 millones de años de historia de nuestro universo.

El escritor danés y humorista Robert Petersen, entre otros, dijo una vez: "Es difícil hacer predicciones, especialmente sobre el futuro." Ello puede ser igualmente difícil con el pasado. Aquellos que trabajan para simular la edad oscura cósmica esperan las observaciones para poner a prueba su trabajo numérico. Para entonces ver si sus predicciones del pasado se mantienen en el futuro.

Simulaciones.

primeras estrellas binarias.

primeras galaxias enanas.

primeras estrellas masivas.

fuente de la información:

http://ptonline.aip.org/journals/doc/PHTOAD-ft/vol_64/iss_4/51_1.shtml?bypassSSO=1