La segunda ley de la termodinámica establece que la entropía de un sistema cerrado no puede disminuir. Así la caída de un trozo de hielo en un baño caliente y la segunda ley requieren que el hielo se derrita y el agua del baño se enfríe - moviéndo el sistema desde un estado de desequilibrio térmico (baja entropía) hacia un estado de equilibrio térmico (alta entropía). En un sistema aislado (o un baño aislado) este proceso sólo puede moverse en una dirección y es irreversible.

Una idea similar se da dentro de la teoría de la información el principio de Landauer establece que cualquier lógica manipulación irreversible de la información, como borrar un bit de información, equivale a un aumento de la entropía.

Así, por ejemplo, si usted hace una fotocopia de una fotocopia que acaba de hacer de una imágen esta se caracteriza por una degradación y perdida eventual de la información de la imágen. Pero el principio de Landauer establece que la información no es perdida, sino es transformada en energía que se disipa lejos por el acto irreversible de la copia de una copia.

Al traducir esta forma de pensar a la cosmología, Michael Paul Gough propone que a medida que el universo se expande y disminuye la densidad, ricos procesos de información como la formación de estrellas también disminuyen. O, para decirlo en términos más convencionales - cuándo el universo se expande, aumenta la entropía ya que la densidad de energía del universo está siendo constantemente disipada a través de un mayor volumen. Además, hay menos oportunidades para la gravedad de generar procesos de baja entropía, como la formación de estrellas.

la imágen muestra la relación entre la entropía e información ,más interesante y rica información existe en bajos estados de entropía que en altos estados de entropía.

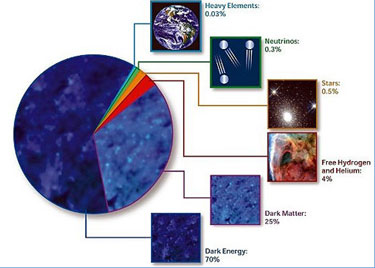

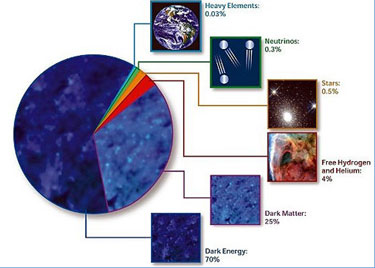

un nuevo estudio intenta relacionar a la energía causante de la expansión del universo ,con la perdida de información de este a medida que se expande este modelo es llamado "Holographic Dark Information Energy" y según su autor entre sus ventajas está el explicar la actual composición masa-energía del universo es decir un 70% de energía oscura y el resto entre materia oscura y materia bariónica.

Así que en un universo en expansión se produce una pérdida de información - y por el principio de Landauer esta pérdida de información debería liberar la energía disipada – y Gough afirma que esta energía disipada representa el componente deenergía oscura del actual modelo estándar del universo.

Hay objeciones racionales a esta propuesta , el principio de Landauer es realmente una expresión de la entropía en los sistemas de información – los cuales pueden ser modelados matemáticamente como si fueran sistemas termodinámicos. Es una afirmación audaz decir que esto tiene una realidad física y que una pérdida de información efectivamente libera energía - y dado que el principio de Landauer expresa esto en forma de energía calórica, ¿no sería entonces esta energía detectable (es decir, no oscura)?

Existe alguna evidencia experimental de pérdida de Información liberándo energía , pero ello podría decirse que es sólo la conversión de una forma de energía a otra - el aspecto de la pérdida de información sólo representaría la transición de baja a alta entropía, como lo requiere la segunda ley de la termodinámica. La propuesta de Gough requiere que la "nueva" energía sea introducida en el universo de la nada -, aunque para ser justos, es más o menos lo que la actual hipótesis de la energía oscura también requiere.

Sin embargo, Gough alega que los cálculos de la energía de información hace un mucho mejor trabajo para dar cuenta de la energía oscura que la hipótesis cuántica tradicional de la energía del vacío la cual predice que la energía oscura debería ser aproximadamente 120 órdenes de magnitud mayor de lo que aparentemente es.

Gough calcula que la energía de la información en la era actual del universo debería ser cerca de tres veces su actual contenido masa-energía – lo cual se alinea estrechamente con el actual modelo estándar de 74% de energía oscura + 26% de todo lo demás.

Invocar el principio holográfico no agrega mucho a la física de los argumentos de Gough - presumiblemente está ahí para hacer las matemáticas más fácil de gestionar mediante la eliminación de una dimensión. El principio holográfico dice que toda la información sobre los fenómenos físicos que tienen lugar dentro de una región del espacio en 3D puede ser contenida en una superficie 2D delimitándo esa región del espacio. Esto, como en la teoría de la información y la entropía, es algo en que los teóricos de cuerdas se la pasan mucho tiempo pensando - no es que haya nada malo en ello.

autor del artículo el astrónomo Steve Nerlich para Universe Today.

leer el estudio AQUÍ

fuente de la información:

http://www.universetoday.com/85855/astronomy-without-a-telescope-holographic-dark-information-energy/

Los científicos del Instituto Max Planck de Óptica Cuántica prepararon un entrelazamiento mecánico cuántico de dos sistemas cuánticos remotos.

Debido a sus extrañas consecuencias el fenómeno de la mecánica cuántica del entrelazamiento fue llamado "acción fantasmal a distancia", por Albert Einstein. Desde hace varios años los físicos han estado desarrollando los conceptos de cómo utilizar este fenómeno para las aplicaciones prácticas tales como la transmisión de datos totalmente seguros. Con este fin, el entrelazamiento el cual se genera en un proceso local tiene que ser distribuido entre los sistemas cuánticos a distancia. Un equipo de científicos encabezados por el Prof. Gerhard Rempe, Director del Instituto Max Planck de Óptica Cuántica y jefe de la División de Dinámica Cuántica, ha demostrado que dos sistemas cuánticos atómicos remotos se pueden preparar en un compartido estado de "entrelazamiento" ,uno de los sistema es un solo átomo atrapado en un resonador óptico, el otro es un condensado Bose-Einstein que consta de cientos de miles de átomos ultra-fríos. Con el sistema híbrido así generado, los investigadores han realizado un bloque de construcción fundamental de una red cuántica.

un átomo sencillo y un BEC en dos laboratorios separados sirvieron como nodos en una básica red cuántica.Para preparar el entrelazamiento entre estos sistemas un pulso laser es utilizado para estimular al átomo para que emita un fotón sencillo el cuál está entrelazado con el átomo sencillo .El fotón es usado para transportar el entrelazamiento a través de una fibra óptica hacia un laboratorio vecino.Allí el fotón es almacenado en el BEC.Este proceso establece el entrelazamiento entre el átomo sencillo y el BEC.Después de algún tiempo el fotón es recuperado del BEC y el estado del átomo sencillo es precisado a partir de un segundo fotón.La observación del entrelazamiento entre estos dos fotones prueba que todos los pasos del experimento fueron llevados satisfactoriamente.Crédito.Gerhard Rempe.

En el fenómeno de la mecánica cuántica del "entrelazamiento" dos sistemas cuánticos están acoplados de tal manera que sus propiedades están estrictamente correlacionadas. Esto requiere que las partículas estén en contacto cercano.Para muchas aplicaciones en una red cuántica, sin embargo, es necesario que el entrelazamiento sea compartido entre dos nodos remotos (bits cuánticos"estacionarios" ). Una forma de lograr esto es utilizar fotones (bits cuánticos "voladores" ) para transportar el entrelazamiento. Esto es algo análogo a las telecomunicaciones clásicas, donde la luz se utiliza para transmitir información entre ordenadores o teléfonos. En el caso de una red cuántica, sin embargo, esta tarea es mucho más difícil, ya que los estados cuánticos entrelazados son extremadamente frágiles y sólo pueden sobrevivir si las partículas están bien aisladas de su entorno.

El equipo del profesor Rempe ahora ha saltado este obstáculo mediante la preparación de dos sistemas cuánticos atómicos situados en dos laboratorios diferentes en un estado entrelazado: por un lado, un sencillo átomo de rubidio atrapado dentro de un resonador óptico formado por dos espejos altamente reflectantes, por otro lado un conjunto de cientos de miles de átomos de rubidio ultrafríos los cuales forman un condensado de Bose Einstein (BEC). En un BEC, todas las partículas tienen las mismas propiedades cuánticas de modo que todas actúan como un solo "superátomo".

En primer lugar, un pulso de láser estimula el átomo sencillo para emitir un solo fotón. En este proceso, los grados de libertadinternos del átomo están acoplados a la polarización del fotón, por lo que ambas partículas se entrelazan. El fotón es transportado a través de una fibra óptica de 30 m de largo a un laboratorio vecino donde se dirige hacia el BEC. Allí, es absorbido por el conjunto. Este proceso convierte el fotón en una excitación colectiva del BEC. "El intercambio de información cuántica entre los fotones y los sistemas atómicos cuánticos requieren de una fuerte interacción luz-materia", explica Matthias Lettner,un estudiante de doctorado que trabaja en el experimento. "Para el átomo sencillo, lo conseguimos por reflexiones múltiples entre los dos espejos del resonador, mientras que para el BEC la interacción luz-materia se ve reforzada por el gran número de átomos."

En una etapa posterior, los físicos probaron que el átomo sencillo y el BEC están realmente entrelazados. Con este fin, el fotón absorbido en el BEC es recuperado con la ayuda de un pulso de láser y el estado del átomo sencillo es leído por la generación de un segundo fotón. El entrelazamiento de los dos fotones alcanza el 95% del máximo valor posible, lo cual demuestra que el entrelazamiento de los dos sistemas atómicos cuánticos debe haber sido igualmente bueno, o incluso mejor. Por otra parte, el entrelazamiento es detectable por aproximadamente 100 microsegundos.

"Un BEC se adapta muy bien como una memoria cuántica, porque este estado exótico no sufre de las perturbaciones causadas por el movimiento térmico", dice Matthias Lettner. "Esto hace que sea posible almacenar y recuperar información cuántica de alta eficiencia y conservar este estado durante mucho tiempo."

En este experimento, el equipo del profesor Rempe ha realizado un bloque de construcción para una red cuántica que consiste de dos remotos y entrelazados nodos estacionarios .Este es un hito en el camino hacia las redes cuánticas a gran escala en la que, por ejemplo, la información cuántica puede ser transmitida completamente segura. Además, estas redes pueden ayudar a la realización de un ordenador cuántico universal en el que los bits cuánticos puedan ser intercambiados con fotones entre los nodos diseñados para el almacenamiento y procesamiento de información.

leer el estudio AQUÍ

fuente de la información:

http://www.physorg.com/news/2011-05-matter-matter-entanglement-distance.html

Un protón aislado ha sido atrapado y persuadido para que revele la intensidad de su magnetismo, algo que podría ayudar a investigar una pregunta permanente sobre la antimateria.

Muchas partículas subatómicas actúan como imanes diminutos, con su intensidad llamada el "factor- g". Los intentos anteriores para medir el factor- g del protón no fueron precisos, ya que se limitaron a sondear los protones de los átomos, donde los electrones que orbitan encubren las propiedades del protón.

esquema del experimento para determinar el factor-g del protón.El sistema consiste de dos trampas de Penning las cuales están conectadas por electrodos .El electrodo del anillo central de la trampa de análisis está hecho de material ferromagnético.La parte baja de la imágen muestra las magnitudes del campo magnético a lo largo del eje.Crédito.S. Ulmer.

Ahora los físicos liderado por Jochen Walz en la Universidad de Mainz en Alemania han conseguido aislar un solo protón y medir su factor g. Empiezan disparándo electrones a una sustancia: el impacto libera protones, que pueden ser atrapados usando un imán. A continuación, los investigadores lentamente permiten que los protones se escapen hasta que sólo queda uno. El imán hace que el protón solitario "precese" como un trompo, en una frecuencia que depende de su factor-g. Los investigadores deducen esta frecuencia mediante ondas de radio que cambian la orientación del imán del protón sólo cuando su frecuencia encuentra la frecuencia de precesión.

Esto en sí mismo no produce un valor más preciso pára el factor-g que anteriormente, pero lo hará , si la prueba del principio del experimento se repite usando una trampa de mayor precisión, dice Wolfgang Quint, un miembro del equipo del Centro Helmholtz para la Investigación con Iones Pesados en Darmstadt, Alemania.

La técnica también podría ser utilizada para medir el factor g de antiprotones. Se cree que la antimateria es una imagen especular de la materia - exactamente lo mismo pero con una carga opuesta. Si esto es cierto, entonces los factores-g del protón y el antiprotón deberían ser idénticos.

leer el estudio AQUÍ

fuente de la información:

http://www.newscientist.com/article/mg21028094.200-lonely-spunout-proton-reveals-magnetic-secret.html

Como las partículas que constituyen un protón dan lugar a su rotación, o "spin", esto origina una pregunta intrigante abierta en la física de partículas contemporánea. Una técnica que podría proporcionar algunas respuestas se ha desarrollado usando el colisionador de protones polarizados. El trabajo fue publicado por la Colaboración PHENIX, que incluye investigadores del RIKENy del Brookhaven National Laboratory (BNL) Centro de Investigación en Upton, EE.UU..

Hoy en día, la teoría más popular para las partículas subatómicas es el Modelo Estándar: una colección de partículas fundamentales, que incluye a los quarks, los cuales vienen en seis tipos de diferentes sabores, y las cuatro fuerzas fundamentales.Estas fuerzas incluyen la "fuerza débil" que está mediada por partículas llamadas bosones W, que se crean, aunque sólo sea brevemente, cuando los protones chocan. Los investigadores descubrieron que estos bosones W son una sonda sensible de los quarks que componen un protón .

cuando dos haces de protones colisionan(centro),los electrones(e-)producidos por el bosón W el cual media en la interacción provee información acerca de los diferentes "sabores" de quarks de un protón tales como el quark anti-up (ū) y el quark down (d)Crédito: Brookhaven National Laboratory.

Para investigar el spin del protón, el equipo PHENIX disparó dos haces de protones de alta energía el uno al otro con elColisionador de Iones Pesados Relativistas en el BNL. "La mayoría de las interacciones que tienen lugar cuando los protones colisionan son" interacciones fuertes ", explica Okada. "Pero nuestro experimento fué lo suficientemente sensible para detectar" interacciones débiles " también. Los investigadores identificaron dos de tales reacciones débiles: la detección de un electrónindicando la desintegración de un bosón W con carga negativa (ver Fig), y la detección de un positrón, un electrón con carga positiva-indicándo la desintegración de un bosón W con carga positiva. Al contar el número de electrones y positrones que resulta, los investigadores pudieron calcular la probabilidad de cada tipo de interacción.

El equipo de PHENIX a continuación, realizó dos experimentos de forma simultánea. En uno, hicieron que los spines de los protones fueran paralelos al eje del haz y en el otro, hicieron que los spines estuvieran en la dirección opuesta. La diferencia en las tasas de las interacciones débiles en cada experimento proporcionó información sobre la dirección del spin de los quarks en el protón. "La asimetría de la producción de tasas está relacionada con la probabilidad de que el spin de un sabor particular de quark este alineado con la dirección del spin del protón", dice Okada. Este enfoque podría extenderse pronto para determinar la contribución al spin de todos los quarks del protón.

Próximamente , el equipo espera mejorar la sensibilidad del experimento. "Esta vez, sólo capturamos electrones y positrones que surgieron a 90 grados del eje del haz", explica Okada. "Estamos preparando nuevos detectores para ampliar la región de detección para un análisis más completo."

leer el estudio AQUÍ

fuente de la información:

http://www.physorg.com/news/2011-05-tool-proton.html

Un equipo internacional de investigadores logró en el Instituto Max Planck de Óptica Cuántica controlar y monitoriar electrones fuertemente acelerados desde nano-esferas con intensos pulsos láser extremadamente cortos.

Cuando la luz láser intensa interactúa con electrones en nanopartículas las cuales constan de muchos millones de átomos individuales, estos electrones pueden ser liberados y acelerados con fuerza.

la imágen muestra el mecanismo de aceleración de electrones cerca de nanoesferas de silice.Los electrones (representados como partículas verdes) son liberados por el campo del láser (onda de color rojo).Estos electrones son primero acelerados lejos de la superficie de la nanoesfera y luego conducidos de regreso a ella por el campo láser .Después de una colisión elástica con la superficie ellos son acelerado lejos de nuevo y alcanzan muy altas energías cinéticas .La figura muestra tres instantáneas de la aceleración (de izquierda a derecha)1) Los electrones son detenidos y obligados a volver a la superficie 2) Cuando alcanzan la superficie ellos elásticamente rebotan de regreso 3)Los electrones son acelerados lejos desde la superficie alcanzando altas energías cinéticas.

Tal efecto en nano-esferas de sílice se observó recientemente por un equipo internacional de investigadores en el Laboratory for Attosecond Physics (LAP) en el Instituto Max Planck de Óptica Cuántica . Los investigadores informan cómo campos eléctricos fuertes(campos cercanos) se acumulan en las proximidades de las nanopartículas y liberan electrones. Impulsados por los campos cercanos y las interacciones colectivas de las cargas resultantes de la ionización por la luz láser, los electrones liberados son acelerados, de manera que puedan exceder en mucho los límites de la aceleración que se han observado hasta el momento de átomos individuales. El movimiento exacto de los electrones puede ser controlado con precisión a través del campo eléctrico de la luz láser. Los nuevos conocimientos sobre este proceso controlado por la luz pueden ayudar a generar extrema radiación ultravioleta (XUV). Los experimentos y sus modelos teóricos, que son descritos por los científicos en la revista Nature Physics , abren nuevas perspectivas para el desarrollo de la ultrarrápida nanoelectrónica,de luz controlada, la cual podría operar hasta un millón de veces más rápido que la electrónica actual.

La aceleración de electrones en un campo láser es similar a un rally corto en un match de ping pong: un servicio, una devolución y un rompimiento aseguran el punto.Un escenario similar se produce cuando los electrones en las nanopartículas son golpeados por pulsos de luz. Un equipo internacional, liderado por tres grupos alemanes incluyendo al profesor Matthias Kling, del Instituto Max Planck de Óptica Cuántica en Garching el profesor Eckart Rühl de la Universidad Libre de Berlín y el Prof. Thomas Hinojo de la Universidad de Rostock, ahora tienen éxito en la observación de los mecanismos y las consecuencias de tal juego de ping pong de los electrones en las nanopartículas luego de interactuar con una fuerte luz láser.

leer el estudio AQUÍ

fuente de la información:

http://www.physorg.com/news/2011-04-electron-ping-pong-nano-world.html

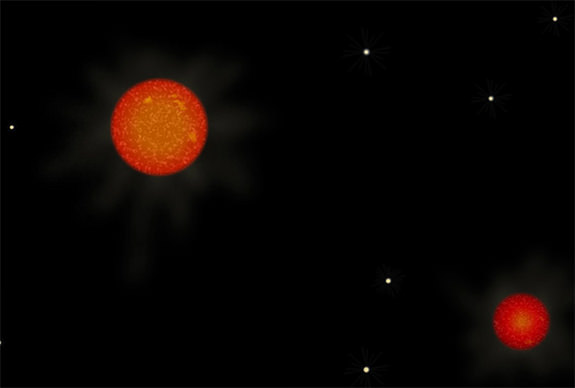

El catálogo SLoWPoKES (Sloan Low-mass Wide Pairs of Kinematically Equivalent Stars ) fué recientemente anunciado, conteniendo 1.342 objetos pares con movimiento propio común (es decir, binarias) – los cuales son todas estrellas de baja masa en el medio de las clases estelares K y M - en otras palabras enanas naranja y rojas.

Estos pares de objetos de baja masa están separados al menos por 500 unidades astronómicas de distancia el uno del otro - y en ese momento la gravitación mutua entre los dos objetos se vuelve bastante tenue – de acuerdo a Newton. Este contexto proporciona un banco de pruebas para algo que está en el reino de la "ciencia alternativa" - es decir, la Dinámica Newtoniana Modificada o MOND.

El origen de la teoría MOND se atribuye generalmente a un trabajo de Milgrom en 1981 (ver aquí), el cual proponía a MOND como una vía alternativa para tener en cuenta la dinámica de los discos de las galaxias y los cúmulos de galaxias. Estas estructuras, obviamente, no pueden mantenerse unidas, con las velocidades de rotación que poseen, sin la adición de una "masa invisible" - o lo que en estos días llamamos materia oscura .

un reciente estudio del movimiento orbital de distantes enanas rojas binarias ofrece un respaldo a la teoría Mond de la gravedad para escalas de 7000 unidades astronómicas.Crédito: NASA.

la imágen de la izquierda muestra la inusual curva plana (B) de las velocidades de los objetos en los discos de las galaxias en contra de lo que se esperaría por una sencilla aplicación de la tercera ley de Kepler (A).La imágen de la derecha muestra un cuadro del esparcimiento de las estrellas binarias seleccionadas del catálogo SLoWPoKE (puntos azules) dibujadas en contra del esparcimiento esperado al aplicar la tercera ley de Kepler (línea roja).Nota:La aplicación de la tercera ley de Kepler del movimiento planetario es adecuada en el contexto del sistema solar donde el 99% de la masa está contenida en el sol ,su aplicación al movimiento de estrellas en un disco galáctico con una distribución de masa más uniforme es incierta.Crédito: Hernandez et al.

MOND pretende impugnar una hipótesis fundamental en la construcción de las teorías de la gravedad de Newton y Einstein - cuando la fuerza de la gravedad (o la curvatura del espacio-tiempo) ejercida por un objeto masivo se aleja por el inverso del cuadrado de la distancia de él. Ambas teorías asumen que esta relación es universal - no importa lo que la masa es o lo que es la distancia, esta relación debe mantener siempre.

De una manera indirecta, MOND propone una modificación a la Segunda Ley de Newton del movimiento - en donde la fuerza es igual a la masa por aceleración (F = ma) - aunque en este contexto "a" , es en realidad una representación de la fuerza de la gravedad (que se expresa como una aceleración).

Si "a" expresa la fuerza gravitatoria, entonces F expresa el principio del peso. Así, por ejemplo, usted puede ejercer una fuerza suficiente para levantar un ladrillo de la superficie de la Tierra, pero es poco probable que usted será capaz de levantar un ladrillo, con la misma masa, sobre la superficie de una estrella de neutrones.

De todos modos, la idea de MOND es que tras permitir que F = ma tenga una relación no-lineal para valores bajos de "a" , una fuerza gravitacional muy tenue actuando a través de una gran distancia todavía podría ser capaz de mantener alguna cosa en una órbita libre alrededor de una galaxia , a pesar del principio de una relación lineal F = ma la cuál predice que esto no debería ocurrir.

MOND es la ciencia alternativa, una afirmación extraordinaria que requiere pruebas extraordinarias, ya que si las teorías de la gravedad de Newton o Einstein no se pueden suponer universales, un montón de otros principios físicos, astrofísicos y cosmológicos comenzarían a desentrañarse.

Además, MOND en realidad no explica una evidencia observacional de la materia oscura - en particular el efecto de lente gravitatoria visto en diferentes galaxias y cúmulos galácticos - un grado de lenteado que excede lo que se espera de la cantidad de masa visible que contienen.

En cualquier caso, los astrónomos X Hernández , C Allen y Maria Alejandra Jiménez han presentado un análisis de los datos extraídos de la base de datos Slowpokes de ampliamente esparcidas binarias de baja masa, lo que sugiere que MOND realmente podría funcionar a escalas de aproximadamente 7000 unidades astronómicas (ver aquí).

El concepto de "masa faltante" o materia oscura se ha manejado durante casi 90 años - sin-aparentemente estar más cerca de determinar qué es esa cosa .Sobre esta base, es razonable el conocer al menos algunos puntos de vista alternativos.

autor del artículo el astrónomo Steve Nerlich para Universe Today.

fuente de la información:

http://www.universetoday.com/85681/astronomy-without-a-telescope-%E2%80%93-slowpokes/

Dependiéndo de su origen,las ondas gravitatorias (las cuales nunca han sido observadas)-podrían aparecer en casi cualquier frecuencia. Cada detector de ondas de gravedad ha sido diseñado para ser sensible en un tramo diferente del espectro. Ahora, escribiendo en la revista Physical Review Letters, un equipo de científicos en Japón describe las primeras pruebas de un detector que es sensible a un rango de frecuencia no capturado por los demás.

El año pasado, Masaki Ando, en la Universidad de Kyoto, y sus colegas propusieron la construcción de un detector que detecta las ondas de gravedad mediante el seguimiento del ángulo relativo entre dos suspendidas masas de barras. Esta antena de torsión de barra, o "TOBA", sería sensible a las ondas de gravedad entre el 1 MHz y 1 Hz, una gama de frecuencias por debajo del detector LIGO- posado en tierra, pero por encima del propuesto interferómetro espacial LISA.

En una primera prueba de su sensibilidad detectora el mismo grupo ha diseñado una mini-versión que consiste en una barra en forma de T invertida (de cerca de 22 cm de diámetro). Un imán en un extremo de la barra permite al equipo la suspensión de la masa, sin contacto, desde un pivote superconductor, mientras que la configuración de un láser interferométrico hace el seguimiento de la flexión de la barra.

La miniatura TOBA proporciona un cálculo aproximado de la sensibilidad del detector, pero el equipo espera más de tres etapas de diseño antes de escalar hasta la versión final con 10 - m de ancho de las barras.

leer el estudio aquí

fuente de la información:

http://physics.aps.org/synopsis-for/10.1103/PhysRevLett.106.161101

La cromodinámica cuántica (QCD) es la teoría del campo cuántico fundamental que describe las interacciones de quarks ygluones. Sin embargo, para estados ligados de quarks (por ejemplo, bariones), el acoplamiento fuerte en estas escalas de energía se complica con la QCD. La complejidad computacional aumenta cuando se consideran estados ligados de bariones. Simulaciones numéricas directas de la QCD formuladas en una red espacio-tiempo ofrecen las mejores esperanzas, sin embargo, estos estudios son muy exigentes computacionalmente.

En dos artículos que aparecen en la revista Physical Review Letters, dos grupos informan de progresos en la simulación de sistemas de dos-bariones -. Estudian un sistema de dos -bariones con extrañeza=-2 e isospín = 0 .La Colaboración NPLQCD directamente calcula la energía del estado ligado, que se define como la diferencia de energía entre el menor de los estados dos -barion interactuantes y la energía de dos bariones Λ libres en reposo. Mientras tanto, la colaboración HAL QCD obtiene la energía del estado ligado indirectamente , calculando primero un potencial dos-Λ. Las energías de dos bariones obtenidas por ambos grupos son más pequeñas que la masa combinada de dos bariones aislados, lo cual confirma la naturaleza de estado ligado del sistema de dos bariones el llamado – dibaryon H, previsto por primera vez por Robert Jaffe en 1977.

Estas son las primeras predicciones fiables del estado ligado de dos bariones a partir de primeros principios, y es probable que inspiren a estudios más detallados Una advertencia: es el caso con más redes de simulaciones donde las masas de los quark arriba / abajo que se utilizan en estos cálculos son más pesadas que en la naturaleza , por lo tanto serán necesarios más cálculos para comprobar si el estado ligado del dibaryon H existe con los quark arriba / abajo de la naturaleza, o si ello es tal vez un umbral de resonancia cercano.

leer los estudios aquí y aquí

fuente de la información:

http://physics.aps.org/synopsis-for/10.1103/PhysRevLett.106.162001

Precisas observaciones cosmológicas sugieren que cerca de tres cuartas partes de la masa-energía del universo es una mal entendida "energía oscura" que impulsa la expansión global. La mayoría del resto se llama "materia oscura", que interactúa con la materia ordinaria y la luz sólo a través de su gravedad. Los agrupamientos de la materia oscura en el universo temprano, registradas en pequeñas variaciones en el fondo de microondas, se cree que desencadenaron el colápso de la materia en las estructuras cosmológicas que vemos hoy.

Dado que la materia oscura se cree que interactúa con ella misma sólo a través de la fuerza gravitacional, las simulaciones predicen que se acumulará de manera espectacular en todos los grandes grupos de materia. Estos agudos picos en la distribución de materia oscura se enfrenta a aquella que se infiere de las observaciones de los cúmulos de galaxias. Pero en "pequeñas" estructuras, tales como galaxias enanas, la dinámica de las estrellas en su lugar indican un más esparcido núcleo. En un artículo que aparece en la revista Physical Review Letters, Abraham Loeb de la Universidad de Harvard y Neil Weiner de la Universidad de Nueva York indican que los núcleos de materia oscura , en contraposición a los picos, surgen si las partículas de materia oscura se dispersan entre sí. Esta idea fue propuesta hace una década, pero no explicó por qué estructuras más grandes no tienen núcleo. Ahora, Loeb y Weiner muestran que, si la interacción (que por ahora tiene un origen desconocido) tiene un alcance finito, tiene un efecto más débil sobre partículas que se mueven rápidamente respecto las unas de las otras, por lo que ellos esperan que se dé en grandes estructuras, pero no en las más pequeñas.

leer el estudio aquí

fuente de la información:

http://physics.aps.org/synopsis-for/10.1103/PhysRevLett.106.171302

En una batalla entre los principios estrellas de la historia cuántica, sólo puede haber un ganador. O no puede? . En el invierno de 1926-1927, Werner Heisenberg el brillante joven alemán estaba trabajando como jefe asistente de Niels Bohr , alojado en un desván en la parte superior del instituto del gran danés de Copenhague. Después de un día de trabajo, Bohr se acercaba al encuentro con Heisenberg para hablar de física cuántica. A menudo se sentaban hasta altas horas de la noche, en un intenso debate sobre el significado de la teoría cuántica revolucionaria, entonces en su infancia.

Un rompecabezas que se ponderó eran los rastros de las gotitas que dejan los electrones al pasar a través de las cámaras de niebla, un aparato utilizado para rastrear los movimientos de partículas cargadas. Cuando Heisenberg trató de cálcular estas aparentemente precisas trayectorias usando las ecuaciones de la mecánica cuántica, no lo consiguió.

Una noche de mediados de febrero, Bohr había dejado la ciudad en un viaje de esquí, y Heisenberg se había deslizado a tomar un poco de aire de la noche en las amplias avenidas de Fælled Parque, detrás del instituto. Mientras caminaba, se le ocurrió. El rastro de los electrones no era preciso en lo absoluto: si uno lo mira de cerca, consiste en una serie de puntos difusos. Eso reveló algo fundamental sobre la teoría cuántica. De vuelta en su ático, Heisenberg escribió con entusiasmo su idea en una carta a su colega el físico Wolfgang Pauli. Lo esencial de esto apareció en un documento unas pocas semanas más tarde: "Mientras más precisa la posición es determinada, menor precisión, en el momento se conoce en este instante, y viceversa."

Así el notorio principio de incertidumbre de Heisenberg había nacido. Una declaración de la incognoscibilidad fundamental del mundo cuántico, que se ha mantenido firme durante la mayor parte del siglo. Pero ¿por cuánto tiempo? Corren rumores de que un segundo principio cuántico – el entrelazamiento- puede sonar el tañido de muerte para la incertidumbre.

el principio de incertidumbre de Heisenberg representa uno de los pilares fundamentales de la mecánica cuántica por no decir el principal nuevos estudios señalan una estrecha relación entre este principio y otro principio de la mecánica cuántica el entrelazamiento cuántico.

¿Es el adiós a Heisenberg y la bienvenida a la certidumbre cuántica?.

Las profundas implicaciones del principio de incertidumbre son difíciles de exagerar. Piense en nuestro clásico sistema solar trabajando como un reloj.Teniendo en cuenta el conocimiento perfecto de las posiciones actuales y los movimientos de los planetas y otros cuerpos, podemos predecir su posición exacta y los movimientos en cualquier momento en el futuro con una precisión casi perfecta. En el mundo cuántico, sin embargo, la incertidumbre elimina cualquier idea de un conocimiento perfecto revelado por la medida (ver "La lógica difusa" al final del artículo). Su afirmación de que hay pares de cantidades "complementarias" tales como la posición y el momento, donde el conocimiento exacto de una se opone al conocimiento de la otra con toda precisión, también socava cualquier concepto de causa y efecto predecible. Si usted no puede conocer el presente en su totalidad, usted puede tener ni idea de lo que depararía el futuro.

Desde el invierno de Copenhague, las generaciones de físicos han puesto a prueba el principio de Heisenberg, a medida que hemos aprendido más acerca de los caprichos de las mediciones cuánticas y el intercambio de información cuántica. La versión ahora favorecida del principio fue construida en 1988 por dos físicos holandeses, Hans Maassenand y José Uffink (ver aquí), utilizando conceptos de la teoría de la información elaborada por el matemático estadounidense Claude Shannon y otros en los años posteriores a la Segunda Guerra Mundial.

Apretó la entropía.

Shannon había mostrado cómo una cantidad que él denominó entropía, por analogía con la medida del desorden termodinámico, proporcionaba un indicador confiable de la imprevisibilidad de la información, y así muy general de la incertidumbre. Por ejemplo, los resultados de lo más reciente en una serie de lanzamientos de moneda tienen la máxima entropía de Shannon, ya que te dicen nada sobre el resultado del siguiente lanzamiento. La información expresada en un lenguaje natural, tales como el Inglés, por el contrario, tienen baja entropía, ya que una serie de palabras proporcionan pistas sobre lo que seguirá.

Traduciéndo este conocimiento en el mundo cuántico, Maassen y Uffink mostraron cómo es posible reducir la entropía de Shannon asociada con cualquier cantidad cuántica medible a cero, y que cuanto más se apriete la entropía de una variable, mayor es el incremento de entropía de las otras . La información que un sistema cuántico da con una mano, la quita con la otra.

Pero es ese siempre el caso? No, de acuerdo con Mario Berta, un teórico de la información cuántica del Instituto Federal Suizo de Tecnología en Zurich, y sus colegas. El entrelazamiento cuántico puede tener un efecto claramente raro en la incertidumbre.

Supongamos que un observador llamado Bob crea un par de partículas, tales como fotones de luz, cuyos estados cuánticos de alguna manera están entrelazados. El entrelazamiento significa que a pesar de que estos estados no se definen hasta que se miden, la medición de uno le dará un valor determinado de inmediato precisándo el estado de la otra partícula.Esto ocurre incluso cuando la distancia entre las dos partículas es demasiado grande para que cualquier influencia viaje entre ellas sin romper el límite de velocidad establecido por la luz cósmica - el proceso que parecía imposible denunciado por Einstein como "acción fantasmal a distancia".

Bob envía uno de estos fotones entrelazados a un segundo observador, Alice, y mantiene el otro encerrado por él en un banco de memoria cuántica - una longitud adecuada de fibra óptica, por ejemplo. Alice entonces al azar mide un par de variables complementarias asociadas a los fotones: en este caso, polarizaciones en dos direcciones diferentes. Su medición se regirá por las reglas habituales de la incertidumbre cuántica, y tan sólo puede tener una precisión de un cierto límite. En términos de Maassen y Uffink, su entropía será distinta de cero. Alice le dice a Bob cuales de las cantidades ella midió, pero no el valor que obtuvo.

Ahora viene la afirmación central.El trabajo de Bob es el de averiguar el resultado de la medición de Alice con la mayor precisión posible. Eso es muy fácil: sólo necesita incursionar en su banco de memoria cuántica. Si los dos fotones están perfectamente entrelazados, el sólo necesita saber cuales cantidades Alice midió y medir él en su propio fotón para obtener un conocimiento perfecto del valor de la medición de Alice – mejor incluso de lo que Alice pueda conocerla. A lo largo de una serie de medidas, el incluso puede reducir su entropía asociada a cero.

El grupo de Berta publicó sus trabajos en julio del año pasado (ver aquí). Apenas unos meses después, dos equipos independientes, encabezados por Robert Prevedel de la Universidad de Waterloo, Ontario, Canadá, y Chuan-Feng Li, de la Universidad de Ciencia y Tecnología de China en Hefei, realizaron las pruebas , resultándo que la incertidumbre puede ser reducida a niveles anteriormente inalcanzables simplemente tras incrementar el entrelazamiento (ver aquí y aquí ). "Los experimentos están en perfecto acuerdo con nuestra relación teóricamente derivada", dice Berta."Nos sorprendió lo rápido que los experimentos se hicieron realidad."

Las primeras reacciones han sido cautelosas. "Esta es una extensión muy bonita e importante de las relaciones de incertidumbre Maassen-Uffink", dice Paul Busch, un teórico cuántico en la Universidad de York, Reino Unido, quién no participó en ninguno de los equipos. Uffink en sí mismo, un investigador de la Universidad de Utrecht en los Países Bajos, está de acuerdo. "Es un trabajo admirable", dice, "pero existe un« pero »."

Ese "pero", Uffink dice, es que incluso si Bob está armado con la memoria y el entrelazamiento cuántico, los experimentos muestran que sólo le es posible predecir con exactitud el resultado de cualquiera de las dos mediciones posibles que Alice hace - no ambas al mismo tiempo.

La incertidumbre está muerta.

Para ambos Uffink y Busch, el experimento mental ideado por Berta y su equipo es una reminiscencia del famoso experimento mental "EPR" ideado en 1935 por Einstein y sus colegas Boris Podolsky y Nathan Rosen. El, también, llega a una conclusión similar: que el entrelazamiento podría eliminar toda la incertidumbre de una medición, pero no de ambas a la vez. De acuerdo con el escepticismo general de Einstein acerca de la rareza cuántica, él interpretó la tensión entre estos dos principios, como indicación de que la mecánica cuántica estaba incompleta, y que una realidad oculta que yace bajo el mundo cuántico era determinante en el resultado de los experimentos.

Mientras que el debate está ahora en gran medida considerado reiterado (ver aquí), el último trabajo abre una perspectiva totalmente nueva. Tradicionalmente, los debates sobre la validez del principio de incertidumbre y la interpretación del experimento EPR se han mantenido diferentes.Ahora hay otra posibilidad: que la incertidumbre no está muerta, sino que existe una relación entre la incertidumbre y el entrelazamiento que todavía no ha sido totalmente apreciada.

"Ellas son dos caras de una misma moneda", dijo Busch. Cuando dos partículas están perfectamente entrelazadas, la acción fantasmal a distancia es la que manda, y la incertidumbre es un principio menos estricto de lo que se había supuesto. Pero donde no hay entrelazamiento, la incertidumbre recurre a la relación Maassen-Uffink.La fuerza de la interpretación de Berta es que nos permite decir lo mucho que se puede saber con una escala móvil de situaciones en el medio, donde el entrelazamiento está presente pero menos que perfecto.Eso es de gran relevancia para la criptografía cuántica, la tecnología cuántica más cercana a la aplicación del mundo real, que se basa en el intercambio de partículas perfectamente entrelazadas. La relación significa que hay una manera más fácil de probar cuando ese entrelazamiento se ha alterado, por ejemplo por fisgones no deseados, simplemente mediante el control de la incertidumbre de medición.

En cuanto al duelo entre la incertidumbre y el entrelazamiento, el termina en empate, con los dos principios convertiéndose en los mejores amigos después del evento. "Debido a que son ahora parte integrante del mismo esquema matemático, no se puede escoger uno y decir que ese es lógicamente superior al otro, o al revés, porque todo está lógicamente relacionado de alguna manera", dijo Busch.

Pero, él dice - hay otro "pero" -, mientras que sea cierto dentro de los límites de la teoría cuántica, nosotros podríamos ser capaces de decir cuál es el principio más fuerte alejando la imagen y teniendo en cuenta un marco matemático más general que el de la teoría cuántica.

Un juego cuántico que Stephanie Wehner jugó, puede ayudar a explicar. Junto con Jonathan Oppenheim de la Universidad de Cambridge, Wehner, una investigadora de la Universidad Nacional de Singapur, jugó con los niños de 12 años de edad, en un café. Ella les dió un tablero con dos cuadrados , y entregó a un niño un zoológico de dos tigres y dos elefantes. El niño podría colocar un tigre en cada cuadro, un elefante en cada cuadro, o un tigre sobre uno y un elefante sobre el otro. Sin mirar, un segundo niño tenía que adivinar qué animal estaba en uno de los cuadros.

"Eso les hizo entender por qué no es posible ganar todo el tiempo", dice Wehner. Sin alguna ilícita participación o extracción de información, sólo podían esperar acierto en la mitad de las veces.

La importancia del juego es que expresa cuestiones de incertidumbre y de entrelazamiento en términos de recuperación de información. Adivinar un animal o un estado de fotones correctamente depende de la correlación entre la información ya almacenada y la información que se solicita. El entrelazamiento proporciona una manera de aumentar esa correlación - efectivamente, hacer trampa.

Larga vida a la incertidumbre.

Curiosamente, sin embargo, hasta la rara "no-localidad ", encarnada por el entrelazamiento no garantiza el éxito. Sin embargo, es posible prever las teorías que no rompan las leyes de la física - en particular, la estricta condición de que ninguna influencia debe viajar más rápido que la luz, establecida en la teoría especial de la relatividad de Einstein - y todavía le permiten estar en lo cierto al 100 por ciento del tiempo (ver aquí).¿Qué es lo que mantiene la teoría cuántica tan rara como es?

La respuesta de Oppenheim y Wehner, publicada en noviembre del año pasado, es desarmadamente simple: el principio de incertidumbre (ver aquí).

Es un giro satisfactorio para la historia. Dentro de los límites de la teoría cuántica, el entrelazamiento puede ayudar a romper la incertidumbre, lo que nos permite estar más seguros sobre el resultado de ciertos experimentos de lo que el principio de incertidumbre solo permitiría. En este nivel, el entrelazamiento alcanza triunfos. Pero aleja la pregunta de cómo los confines de la teoría cuántica se establecen, y parece que es el principio de incertidumbre el que para las cosas en el mundo cuántico siendo (ambos principios) más raros y más correlacionados de lo que ya son.Las normas de la incertidumbre, ponen al entrelazamiento en una camisa de fuerza. "Esto demuestra claramente que el principio de incertidumbre está lejos de estar muerto", dijo Busch.

Iwo Bialynicki-Birula, un físico que hizo el trabajo seminal de reformular el principio de incertidumbre en términos de la información en la década de 1970 (ver aquí) , escribió una vez que toda teoría física tiene una ecuación llamativa para adornar una camiseta. Así como la relatividad tiene su E = mc2, la mecánica cuántica tiene su relación de incertidumbre.

Lógica difusa.

En el documento de 1927 que introdujo el principio de incertidumbre para el mundo (ver aquí), Werner Heisenberg establece que hay pares de cantidades en el mundo cuántico que no pueden ser medidas a un nivel arbitrario de precisión, al mismo tiempo.Tales pares son la posición y el momento - esencialmente en la medición del movimiento de una partícula cuántica. Si usted conoce la posición x de una partícula dentro de una cierta exactitud Δx, entonces la incertidumbre Δp en su momento p viene dada por la desigualdad matemática Δx. Δp ≥ ħ/2. Aquí, ħ es un número fijo de la naturaleza conocida como la constante reducida de Planck.

Esta desigualdad dice que, en conjunto, Δx y Δp no pueden socavar ħ / 2. Así pues, en general, cuanto más sabemos acerca de dónde está una partícula (el más pequeño Δx ), menos podemos saber donde está (el más grande Δp ), y viceversa.

El principio de incertidumbre también se aplica a otros pares de cantidades, como la energía y el tiempo, y los spines y polarizaciones de las partículas en varias direcciones. La relación de incertidumbre energía-tiempo es la razón por la cual las partículas cuánticas pueden salir de la nada y desaparecer otra vez.

Pruebas cuántica que no van a matar al gato de Schrödinger.

Puede pronto ser posible extraer información de un objeto cuántico - e incluso manipularlo - sin que ello implique la destrucción de su delicado estado cuántico. El resultado sería una bendición para la computación cuántica, la cual requiere el control sobre tales estados. También iría en contra de un experimento ideado por el físico Erwin Schrödinger: en principio, ahora es posible echar un vistazo dentro de su caja sin poner en peligro la vida precaria del minino en su interior.

Los estados que son mutuamente excluyentes en la física clásica pueden existir simultáneamente en el extraño mundo de la mecánica cuántica - una situación llamada superposición. Para ilustrar este efecto, Schrödinger imaginó poner un gato en una caja junto con un dispositivo que liberaría veneno para matarlo, en función de la desintegración al azar de un átomo radiactivo. Dado que el estado cuántico del átomo sólo tiene un valor determinado cuando alguien lo mira, el gato está a la vez vivo y muerto hasta que la caja se abre.

Las superposiciones son frágiles, sin embargo. las perturbaciones exteriores, incluidas las observaciones, tienden a destruir la "coherencia" de estos estados, obligando a que el sistema colapse en una de las posibilidades. Cuanto mayor sea el sistema, más difícil será para aislarlo de las influencias externas.

En el 2010, los físicos colocaron el sistema más grande aún en una superposición(ver aquí): una franja de 40 micras de largo de material piezoeléctrico, que se expandía y contraía en respuesta a las variaciones de tensión. Lo pusieron en una superposición de ambos mínima y más vigorosa oscilación, pero el método que utilizaron para observar el sistema provocó la pérdida de dicho estado dual.

Otro equipo propone ahora ir un paso más allá, poniendo un cable de aproximadamente el mismo tamaño en una superposición y ofreciéndo un esquema de observar, e incluso manipular, sin destruir el extraño estado cuántico. Kurt Jacobs de la Universidad de Massachusetts, en Boston, y su equipo describen su idea en un estudio que aparece en la revista Physical Review A(ver aquí).

El primer paso es poner el cable en una superposición en la que las vibraciones al mismo tiempo lo desplacen en la misma cantidad en direcciones opuestas, como una cuerda de guitarra sacudiéndose en dos direcciones a la vez. A continuación, una carga eléctrica se puede agregar al cable, creando un campo electromagnético que puede ser detectado por un sensor .

A pesar de que el sensor no puede localizar la posición de la carga - y por lo tanto del cable – el puede detectar en qué medida la carga está de una posición neutral. Eso revela algunos datos sobre el sistema – esencialmente proporciona una visión interior de la caja que contiene al gato de Schrödinger. La clave es que evita tener que abrir la caja completamente, lo cual destruiría la superposición, dice Jacobs: "Yo extraje información, pero de una manera que no se aprende demasiado."

Esquemas anteriores vislumbraron dentro de la caja involucrada destruyendo parcialmente la superposición y luego tratando de restaurarla. "En nuestro trabajo, lo crucial es que la medición no destruye la coherencia", dice Jacobs.

El equipo también se propone ajustar la tensión del cable para cambiar el tamaño de las vibraciones, un ajuste que no destruiría la frágil superposición.

La realización de este experimento está todavía unos pocos años en el futuro, el equipo dice - los sensores necesarios para hacer las mediciones más sutiles deben ser menos vulnerables a la interferencia de ruido. Si el experimento con el tiempo resulta en un éxito, sería un paso hacia la computación cuántica.

Las computadoras cuánticas, que aún no se han construido, serían capaces de hacer mucho más cálculos al mismo tiempo de lo que los ordenadores convencionales pueden. Su capacidades se derivan de la capacidad de los sistemas cuánticos de estar en más de un estado simultáneamente. Hacer tales equipos requiere ser capaz de leer y modificar el estado de los sistemas cuánticos, los procesos que el nuevo experimento se propone alcanzar. "Esta propuesta podría ser muy útil," dice Aephraim Steinberg de la Universidad de Toronto en Canadá.

Teletransporte del gato de Schrödinger.

La observación de un objeto en más de un estado cuántico de una vez - en una superposición - sigue siendo un objetivo difícil de alcanzar pero teletransportar un objeto así, es ahora anticuado. Noriyuki Lee de la Universidad de Tokio, Japón, y sus colegas han logrado hacer que la luz en una superposición de estados se desvanezca en un lugar y reaparezca en otro.

Se aprovecharon del entrelazamiento, una propiedad cuántica, que crea una conexión fantasmal entre objetos separados que actúa incluso a distancia. Ellos entrelazaron dos rayos de luz, por lo que la medición de uno afectó al resultado de la medición del otro.Después de mezclar uno de los rayos entrelazados con pulsos de luz en una superposición de muchos estados cuánticos, fueron capaces de recrear la superposición en el segundo haz entrelazado (ver aquí).

"Esto demuestra que la manipulación controlada de los objetos cuánticos ... ha alcanzado los objetivos que parecían imposibles hace apenas unos años", dice Philippe Grangier en el Instituto de Óptica en Palaiseau, Francia.

fuente de la información:

http://www.newscientist.com/article/mg21028101.700-uncertainty-entangled-the-limits-of-quantum-weirdness.html

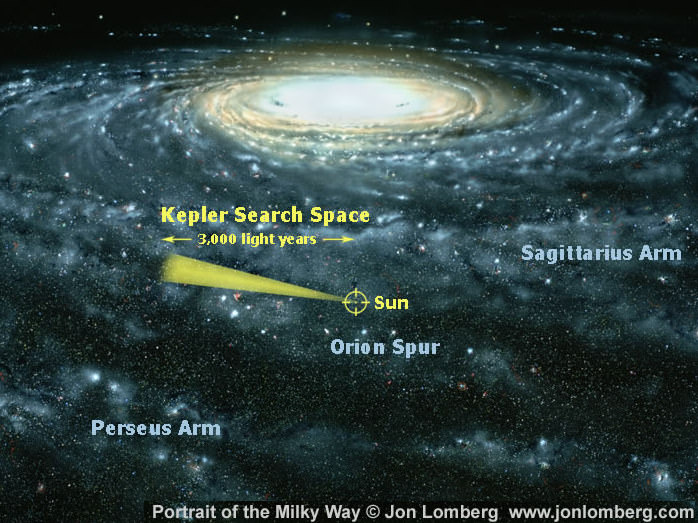

La Enciclopedia de Planetas extrasolares cuenta con 548 planetas extrasolares confirmados al 6 de mayo del 2011, mientras que la base de datos de estrella y exoplanetas de la Nasa (actualizada semanalmente) reporta 535.

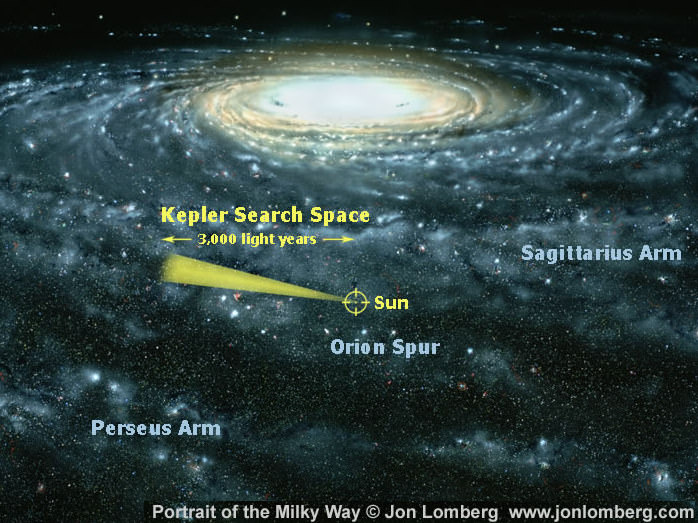

Estos hallazgos son confirmados y la cuenta aumentará significativamente a medida que más exoplanetas candidatos sean evaluados. Por ejemplo, están los 1.235 candidatos anunciados por la misión Kepler en febrero, incluyendo 54 que pueden estar en una zona habitable.

Entonces, ¿qué técnicas se utilizan para llegar a estas conclusiones?.

Sincronización del Pulsar - Un púlsar es una estrella de neutrones con un chorro polar aproximadamente alineado con la Tierra. Cuando la estrella gira y un chorro entra en la línea de visión de la Tierra, se detecta un pulso extremadamente regular de luz. De hecho, es tan regular que un ligero bamboleo en el movimiento de la estrella, debido a los planetas que posee, es detectable.

Los primeros planetas extrasolares (es decir, exoplanetas) se encontraron en esta forma, de hecho, tres de ellos, alrededor del púlsar PSR B1257 +12 en 1992. Por supuesto, esta técnica sólo es útil para encontrar planetas alrededor de púlsares, ninguno de los cuales podría considerarse habitables - al menos por las definiciones actuales - y, en total, sólo cuatro planetas pulsares han sido confirmados hasta la fecha.

la actual área de búsqueda de la misión Kepler monitorea 145000 estrellas por signos de exoplanetas ,con un particular interés en aquellos que pueden estar localizados en la "zona habitable" de la estrella.Crédito: Lomberg/NASA.

imágen directa del exoplaneta Beta Pictoris b obtenida con anulación interferométrica la cual remueve la luz de la estrella Beta Pictoris de la imágen las llamaradas rojas son un disco de desechos circunestelar calentado por la estrella .Crédito.ESO.

Para buscar planetas alrededor de estrellas de la secuencia principal, tenemos ...

El método de la velocidad radial - Este es similar en principio a la detección utilizando anomalías a través de la sincronización del púlsar, donde un planeta o planetas mueven a su estrella hacia atrás y adelante cuando la orbitan, causando pequeños cambios en la velocidad de la estrella con respecto a la Tierra. Estos cambios se miden generalmente como cambios en las líneas espectrales de una estrella, detectables a través de espectrometría Doppler, aunque la detección a través de astrometría(detección directa de minúsculos cambios en la posición de una estrella en el cielo) también es posible.

Hasta la fecha, el método de la velocidad radial ha sido el método más productivo para la detección de exoplanetas (encontró 500 de los 548), aunque con mayor frecuencia detecta planetas masivos en cercanas órbitas estelares (es decir, "Júpiter calientes" ) - y, en consecuencia estos planetas están más que representados en la población actual de exoplanetas confirmados. Además, en aislamiento, el método sólo es efectivo hasta unos 160 años luz de la Tierra - y sólo proporciona la mínima masa, no el tamaño, del exoplaneta.

Para determinar el tamaño de un planeta, se puede utilizar ...

El método del tránsito - El método del tránsito es eficaz tanto en la detección de exoplanetas y determinar su diámetro - a pesar de que tiene una alta tasa de falsos positivos. Una estrella con un planeta en tránsito, el cuál bloquea parcialmente su luz, es por definición una estrella variable . Sin embargo, hay muchas razones por las que una estrella puede ser variable - muchas de las cuales no tienen que ver con un planeta en tránsito.

Por esta razón, el método de velocidad radial se utiliza a menudo para confirmar un hallazgo por el método del tránsito. Así, aunque 128 planetas se atribuyen al método del tránsito - estos también son parte de los 500 contados por el método de la velocidad radial. El método de la velocidad radial proporciona la masa del planeta - y el método del tránsito le da su tamaño (diámetro) - y con estas dos medidas se puede obtener la densidad del planeta. El periodo orbital del planeta (por cualquier método) también proporciona la distancia de los exoplanetas a su estrella, utilizando la Tercera ley Kepler. Y así es como podemos determinar si un planeta está en la zona habitable de una estrella.

También es posible, de la consideración de pequeñas variaciones en la periodicidad del tránsito (es decir, la regularidad) y la duración del tránsito, el identificar otros planetas más pequeños (de hecho, ocho se han encontrado a través de este método, o 12 si se incluyen las detecciones vía sincronización del púlsar). Con el aumento de la sensibilidad en el futuro, también puede ser posible identificar exolunas de esta manera.

El método del tránsito también puede permitir un análisis espectroscópico de la atmósfera de un planeta. Por lo tanto, un objetivo clave es encontrar un análogo de la Tierra en una zona habitable, a continuación, examinar su atmósfera y monitorear sus emisiones electromagnéticas - en otras palabras, buscar señales de vida.

Para encontrar los planetas en órbitas más amplias, se puede probar ...

Imágen directa - Este es un reto ya que un planeta es una fuente de luz tenue cerca de una fuente de luz muy brillante (la estrella). Sin embargo, 24 se han encontrado de esta manera hasta el momento.La anulación interferométrica,donde la luz de una estrella es cancelada a partir de dos observaciones a través de interferencia destructiva, es una manera eficaz para detectar fuentes de luz más débiles ocultas por la luz de la estrella.

La lente gravitatoria - Una estrella puede crear un estrecho lente gravitacional y por lo tanto, ampliar una fuente de luz distante - y si un planeta alrededor de la estrellas se encuentra en la posición correcta inclina ligeramente este efecto de lente, haciendo notar su presencia. Tal evento es relativamente raro - y luego tiene que ser confirmado a través de observaciones repetidas. Sin embargo, este método ha detectado hasta el momento 12 planetas, que incluyen pequeños planetas en órbitas tan amplias como OGLE-2005-BLG-390Lb .

Estas técnicas actuales no esperan obtener un censo completo de todos los planetas dentro de los límites actuales de observación, pero nos ofrecen una idea de cuántos pueden haber por ahí. Se ha estimado a partir de especulativos escasos datos disponibles hasta el momento, que pueden haber 50 mil millones de planetas en nuestra galaxia. Sin embargo, una serie de cuestiones de definición aún no se han tomado en cuenta, como por ejemplo cuando se traza la línea entre un planeta frente a una enana marrón. La Enciclopedia de Planetas extrasolares actualmente fija el límite en 20 masas de Júpiter.

De todos modos, 548 exoplanetas confirmados en sólo 19 años de búsqueda de planetas no es malo. Y la búsqueda continúa.

autor del artículo el astrónomo Steve Nerlich para Universe Today.

fuente de la información:

http://www.universetoday.com/85475/astronomy-without-a-telescope-planet-spotting/